Vol. 39 (Nº 51) Año 2018. Pág. 19

José-Luis TINAJERO 1; Pablo LOZADA 2; Fausto CABRERA 3

Recibido: 13/07/2018 • Aprobado: 30/09/2018 • Publicado 22/12/2018

RESUMEN: El trabajo presenta la implementación de una plataforma móvil para navegación de interiores, con un sistema de control visual que detecta y evade objetos mediante la comparación de patrones y, generando una imagen panorámica del entorno. El sistema de control se basa en el procesamiento de señales detectadas a través de sensores ultrasónicos, que permiten a la plataforma móvil tomar la mejor decisión de desplazamiento, en relación a la distancia y presencia de objetos que son interpretados como obstáculos. |

ABSTRACT: The work presents the implementation of a mobile platform for indoor navigation, with a visual control system that detects and evades objects by comparing patterns and, generating a panoramic image of the environment. The control system is based on the processing of signals, which are detected through ultrasonic sensors that allojw the mobile platform to make the best decision of displacement, regarding the distance and presence of objects that are interpreted as obstacles. |

El diseño e implementación de robots aplicables a diversos ámbitos de las actividades humanas es una tendencia generalizada en la actualidad. Son diversas las propuestas de creación de robots como apoyo por ejemplo a actividades médicas (Botero, Peña, & Mantilla, 2017), educativas (Cianci, Raemy, Pugh, & Martinoli, 2006) e incluso actividades lúdicas y de entretenimiento (Morris, Samonin, Anderson, Lau, & Baltes, 2018). Dentro de las distintas categorías de robots aparece el concepto de robots autónomos cuya operatividad se garantiza con la utilización de dispositivos tecnológicos, propendiendo a lograr una mínima y casi nula intervención humana. En este sentido, el uso de sensores, cámaras y demás dispositivos tecnológicos es una práctica común en el diseño de autómatas para asegurar su integridad y correcto funcionamiento.

La literatura evidencia diversos trabajos respecto al desarrollo de autómatas o sistemas de control de robots utilizando para ello microcontroladores Raspberry Pi, considerando que éstos son comúnmente utilizados en el desarrollo de plataformas móviles. Así, en su investigación, Jiang (2016) utilizó el microcontrolador Raspberry Pi para desarrollar una cámara estéreo inteligente sobre una plataforma móvil para robot de servicio de búsqueda en interiores. Por su parte, Vanitha, Selvalakshmi & Selvarasu (2016) desarrollaron un sistema de monitoreo y control de un robot móvil vía internet a través de una tarjeta Raspberry Pi. En cambio, en el trabajo de Bokade & Ratnaparkhe (2016) se menciona el desarrollo de un sistema de control para un robot de video vigilancia, donde utilizando Raspberry pi y un teléfono inteligente, son enviadas las órdenes a través de una conexión Wi-Fi. Aunque en el entorno latinoamericano son escasos los trabajos realizado sobre esta temática, merece la pena destacar la investigación en la cual se desarrolló la ley de control de un servo visual usando un enfoque de visión 2D, para un sistema robótico de 3 DOF construido con LEGO EV3 y Raspberry Pi (Milena, López, Enrique, & Uribe, 2016).

La presente investigación tiene como finalidad desarrollar un sistema de control visual, capaz de detectar obstáculos ubicados en la parte frontal de una plataforma móvil diferencial, mediante la correlación existente entre las imágenes capturadas por el robot y una base de datos previamente definida. Se utilizó el microprocesador Raspberry Pi 3 conectado de forma inalámbrica con el software Matlab para visualizar, procesar y verificar la toma de decisiones del sistema de control visual. Para construir la fusión sensorial del autómata, se consideró la implementación de un programa cargado sobre una tarjeta Arduino Nano conectada a sensores ultrasónicos, cuya misión es corroborar corroboran la existencia de un objeto frente al robot y determinar la distancia del obstáculo.

Adicionalmente, a través de un sistema de visión artificial se reconstruyó la escena panorámica que permita al autómata interpretar el entorno por donde se desplaza la plataforma móvil diferencial, logrando un sistema de control óptimo y eficiente.

Los robots móviles responde a la necesidad de ampliar el campo de las aplicaciones robóticas, incrementando la autonomía de los elementos y limitando en lo posible la intervención humana (Ollero, 2001). Los robots móviles son cada vez más útiles en aplicaciones avanzadas, debido a su intervención autónoma en situaciones en las que resulta complicada la participación humana (Siciliano, Sciavicco, Villani, & Oriolo, 2009).

La característica principal de los robots móviles es la presencia de una base móvil que permite que el robot se mueva libremente en su entorno. Esta base móvil consiste en uno o varios cuerpos rígidos equipados con su respectivo sistema de locomoción. Comúnmente, los robots móviles suelen estar categorizados en aquellos cuya movilidad se realiza a través de ruedas y aquellos cuya movilidad se realiza usando patas (Siciliano et al., 2009). En general, los robots móviles que disponen de ruedas, son la solución más simple y eficiente para conseguir la movilidad en terrenos duros y libres de obstáculos, logrando alcanzar velocidades relativamente altas (Ollero, 2001).

Los robots móviles articulados con ruedas, que posee la siguiente configuración: una rueda fija que gira alrededor de un eje que pasa por el centro de la rueda y es ortogonal al plano del elemento. La rueda está unida de forma rígida al chasis por lo cual su orientación es constante (Siciliano et al., 2009).

Dentro de los robots móviles, aparece el concepto de Vehículo móvil diferencial, que está conformado por ruedas fijas con un eje de rotación común, y una rueda giratoria que tiene como función proporcionar equilibrio estático a la plataforma. Las ruedas fijas se controlan por separado variando los valores de la velocidad angular, en tanto la rueda giratoria tiene un comportamiento pasivo (Siciliano et al., 2009). El direccionamiento del vehículo móvil se obtiene mediante la diferencia de las velocidades de las ruedas laterales (Ollero, 2001). En la Figura 1 se esquematiza la estructura típica de un vehículo móvil diferencial.

Figura 1

Esquema típico de un vehículo móvil diferencial

Fuente: Elaborada por los autores

Los sensores se encargan de proporcionar la información necesaria para realizar el control del robot. Los sensores pueden ser empleados para la medición de diversos principios físicos y químicos. En la actualidad la mayoría de sensores emplean un procesamiento electrónico, y para que la información sea procesada es necesario que sea recibida en función de señales eléctricas (Ollero, 2001; Wilson, 2004).

Como parte de los sensores que prestan mayores ventajas en base a sus características, se encuentran los llamados sensores ultrasónicos. Estos sensores se caracterizan por emitir pulsos de sonido y calculan el tiempo de vuelo en que tarda en regresar la señal hasta el sensor después de golpear con cualquier objeto. En la presente investigación se utilizó el sensor ultrasónico HC-SR04.

Los controladores son circuitos integrados que en su interior poseen los componentes básicos del procesamiento computacional: CPU, memoria y unidades de entrada y salida (Barros, 2017). Existen diversos tipos de controladores, sin embargo, por sus características tecnológicas y accesibilidad económica, los controladores Raspberry Pi y Arduino Nano son los más populares y comercializados (Casco, 2014).

El controlador Raspberry Pi 3, cuya imagen se ilustra en la Figura 2, corresponde a la tercera generación de tarjetas y posee las siguientes características (Raspberry Pi, 2017):

Figura 2

Tarjeta Raspberry Pi 3

Fuente: https://www.raspberrypi.org

Por su parte el controlador Arduino Nano es una placa basada en el microcontrolador Atmega328, que ofrece la misma conectividad y especificaciones de la placa UNO. La placa es capaz de funcionar tanto en línea como fuera de línea (Arduino CC, 2017).

La investigación realizada presenta un enfoque cuantitativo con alcance descriptivo. Se diseñó e implementó un robot móvil diferencial para navegación en interiores y mediante pruebas de funcionamiento se determinó la capacidad de movilización del autómata y la precisión para reconstruir escenas panorámicas a través de un sistema de visión artificial. Una de las características fundamentales del robot diseñado, fue la posibilidad de detectar y evitar obstáculos a través de un sistema de fusión sensorial.

El trabajo de implementación y experimental estuvo dividido en tres etapas principales: (1) el diseño e implementación de los elementos de hardware, (2) el diseño e implementación de los elementos software y, (3) el diseño del entorno de pruebas.

Para la implementación de la estructura diferencial se consideraron elementos pasivos y activos entre los cuales se pueden destacar: Chasis de 215X150X110mm, Motores CC y ruedas de 65mm de diámetro.

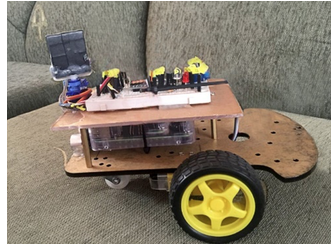

Los motores CC unidos a las ruedas son los encargados del direccionamiento, y se encuentran posicionados a los costados del chasis. La tercera rueda sirve para entregar soporte a la estructura. Bajo esta configuración se logra la construcción de la plataforma móvil diferencial que se ilustra en la Figura 3.

Figura 3

Plataforma Móvil Diferencial construida

Fuente: Elaborada por los autores

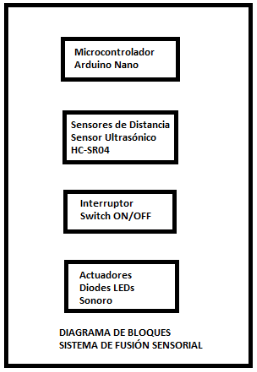

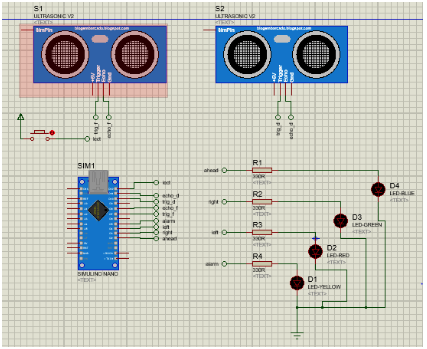

Para el sistema de detección de objetos se empleó una tarjeta Arduino Nano a la cual se conectaros dos sensores ultrasónicos. Estos sensores ultrasónicos, cumplen el objetivo de verificar la existencia de obstáculos, por lo que se ubican en la parte frontal y derecha de la plataforma. En la Figura 4, a través de un diagrama de bloques, se esquematiza los elementos que intervienen en el sistema de fusión sensorial. Por su parte, la Figura 5 ilustra el diseño electrónico desarrollado en Proteus.

Figura 4

Diagrama de Bloques- Sistema Fusión Sensorial

Fuente: Elaborada por los autores

-----

Figura 5

Diseño electrónico del Sistema de Fusión Sensorial

Fuente: Elaborada por los autores

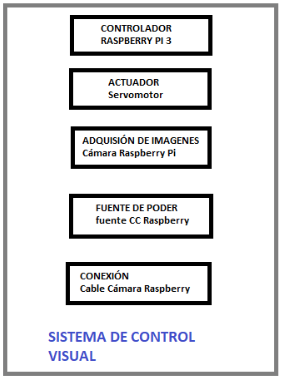

Utilizando el controlador Raspberry Pi, se diseñó el sistema de control visual de navegación, el mismo que está representado a través de un diagrama de bloques en la Figura 6.

Figura 6

Diagramas de Bloques – Sistema de Control Visual

Fuente: Elaborada por los autores

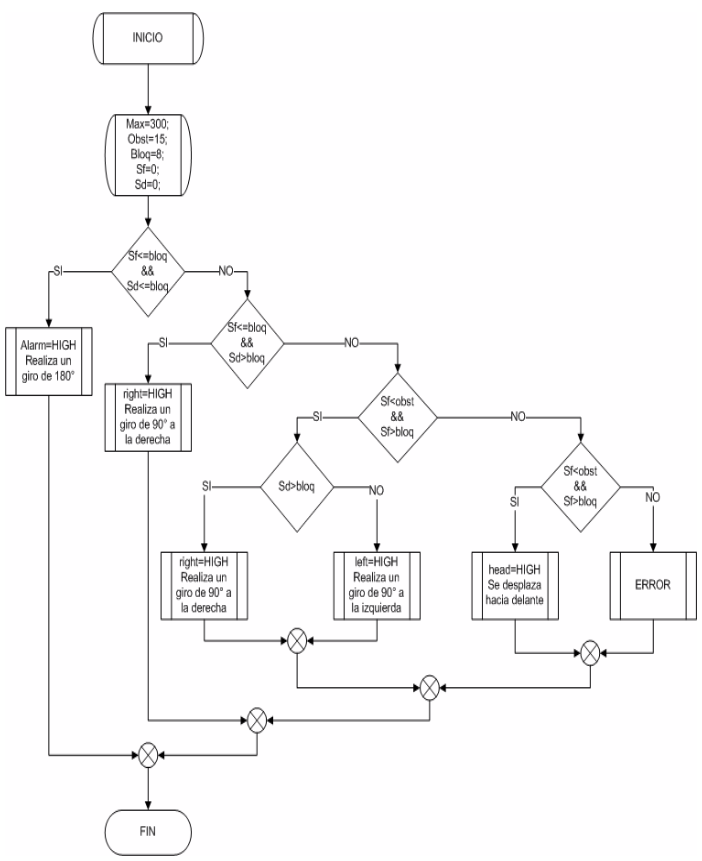

El diseño del software de control de la plataforma móvil se realizó utilizando el microcontrolador Arduino. La primera etapa consistió en la delimitación del área de trabajo. Esta actividad fue necesaria para garantizar el correcto funcionamiento del sistema de detección y evasión de obstáculos. Así, utilizando técnicas de fusión sensorial se delimitó el área de trabajo procurando salvaguardar la integridad de la estructura. La delimitación del área de trabajo se realizó en función de los parámetros descritos en la Tabla 1.

Tabla 1

Parámetros de delimitación del área del trabajo

Parámetro |

Valor |

Distancia Máxima |

300 cm |

Distancia de Obstáculo |

15 cm |

Distancia de Bloqueo |

8 cm |

El proceso de evasión y detección de obstáculos fue programado en base a un conjunto de condiciones anidadas a través de la estructura de programación IF. A través de un diagrama de flujo, en la Figura 7 se esquematiza las instrucciones empleadas para este propósito.

Figura 7

Diagrama de flujo para la detección y evasión de obstáculos

Fuente: Elaborada por los autores

Para el diseño del software de control visual, se utilizó el controlador Raspberry Pi, y las etapas principales efectuadas fueron las siguientes:

Las imágenes obtenidas mediante la cámara a bordo de la tarjeta Raspberry Pi son procesadas para determinar la presencia de obstáculos a los que la plataforma móvil debe evitar. El procesamiento de imágenes contempla las siguientes etapas:

Extracción de color: Las imágenes capturadas se descomponen en sus tres matrices RGB para extraer únicamente la matriz correspondiente al color azul. El canal azul es seleccionado debido a que el uso de técnicas de visión artificial ha demostrado que este color proporciona mejores tiempos de respuesta en su procesamiento. El canal azul extraído de la imagen original, es sometido a un proceso de umbralización que permite segmentar los componentes de la imagen que serán analizados.

Modificación del tipo de imágenes: Luego del proceso de umbralización, las imágenes son transformadas a imágenes binarias, considerando el valor de contraste con el cual se transformará la imagen al formato deseado.

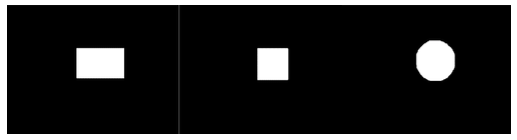

Creación de los elementos estructurantes: Se crean elementos en base a figuras geométricas, que comúnmente son rectángulos, cuadrados y/o circunferencias.

Erosión de Imágenes: Con esta operación se pretende eliminar cualquier bit que distorsione las capturas realizadas. Para ello, se consideran los valores establecidos en los elementos estructurantes.

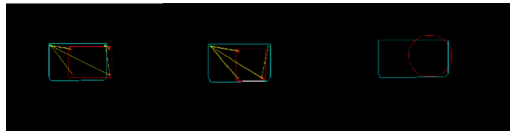

Dilatación de Imágenes: Las imágenes son dilatadas para obtener una forma completamente definida de los elementos en análisis. Un ejemplo del resultado esta operación se ilustra en la Figura 8.

Figura 8

Ejemplo de imagen de los elementos estructurantes dilatados

Fuente: Elaborada por los autores

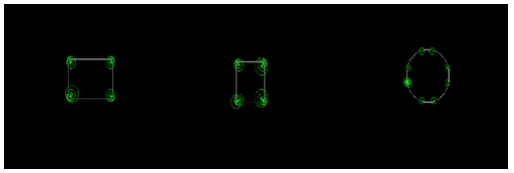

Detección de bordes de las imágenes: Para realizar la detección de los contornos de las imágenes previamente dilatadas, se emplea el “método Canny” (Canny, 1986) puesto que es considerado uno de los mejores métodos para la extracción total del borde de las figuras (Mohamed, Mahmoud, & Ibrahim, 2017).

Detección de los puntos más relevantes de las imágenes: Para la detección de los puntos más importantes de cada una de las imágenes se emplea la función detectSURFFeatures debido a las altas prestaciones que provee en la detección de figuras con varios detalles (Tele, Kathalkar, Mahakalkar, Sahoo, & Dhamane, 2018).Un ejemplo de la aplicación de la función detectSURFFeatures se puede observar en la Figura 9.

Figura 9

Detección de los puntos mas relevantes usando la función detectSURFFeatures

Fuente: Elaborada por los autores

Extracción de los puntos más relevantes de las imágenes: Se compara las imágenes de la extracción de los bordes con la detección de puntos más importantes de la misma captura.

Visualización de la correspondencia de puntos: La visualización de la correspondencia de puntos se realiza entre las imágenes de una base de datos precargada en el sistema, y la imagen que captura el robot en sus desplazamientos. El método empleado para identificar claramente los elementos es “falsecolor” que tiene como característica sobreponer las imágenes que se analizan con diversos colores para que sean comparadas entre sí, uniendo los puntos que son comunes a ambas imágenes. Así, en la Figura 10 se ilustra un ejemplo de la aplicación de faslecolor para la visualización de correspondencia de puntos.

Figura 10

Visualización de la correspondecia de puntos através de falsecolor

Fuente: Elaborada por los autores

Correlación de imágenes: La correlación entre imágenes se la emplea para comparar los píxeles que poseen las dos capturas, e identificar si existe o no un obstáculo delante de la plataforma móvil diferencial, de lo cual depende si el robot avance en línea recta o debe tomar una decisión de giro.

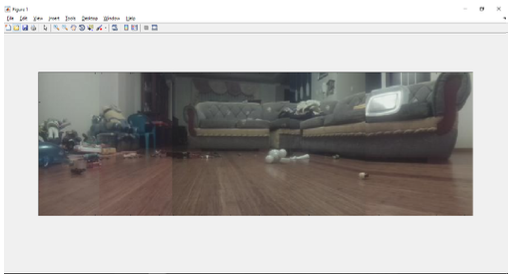

Reconstrucción del entorno: Para realizar la reconstrucción del entorno se considera la correspondencia de imágenes y es necesario que todas las capturas poseen dimensiones exactamente iguales. Un ejemplo de reconstrucción del entorno se aprecia en la Figura 11.

Figura 11

Vista panorámica recostruida por el sistema de control visual

Fuente: Elaborada por los autores

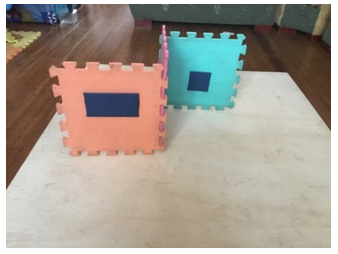

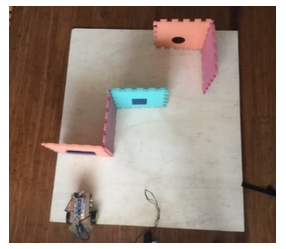

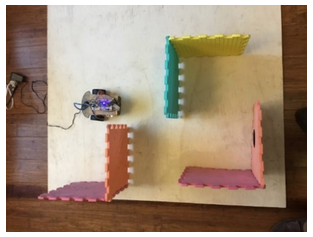

Para verificar el correcto funcionamiento de la configuración de la plataforma móvil se diseñaron como entornos de prueba, cuatro escenarios o pistas en los cuales se analiza diferentes giros y cantidad de objetos que la plataforma es capaz de detectar. Así, las pistas 1 y 2 ilustradas en la Figura 12 y Figura 13 respectivamente, están conformada por dos obstáculos cada una; sin embargo, la pista uno presenta predominancia de giro al lado derecho mientras que en la pista 2 la predominancia es al lado izquierdo. Por otra parte, la pista 3 es una pista híbrida de 3 obstáculos que posee giros en ambas dimensiones direcciones y se ilustra en la Figura 14. Finalmente, la pista 4 es similar a la pista 3 en el sentido que también incluye 3 obstáculos pero, los giros se alternan en ambas direcciones como se puede apreciar en la Figura 15.

Figura 12

Pista de Prueba 1: Dos obstáculos, giro a la derecha

Fuente: Elaborada por los autores

------

Figura 13

Pista de Prueba 2: Dos obstáculos, giro a la izquierda

Fuente: Elaborada por los autores

------

Figura 14

Pista de Prueba 3: Tres obstáculos,

giros derecha, derecha, izquierda

Fuente: Elaborada por los autores

-----

Figura 15

Pista de Prueba 4: Tres obstáculos, giros alternados

Fuente: Elaborada por los autores

La Tabla 2 sintetiza los resultados de las pruebas ejecutadas a fin de determinar el funcionamiento de la plataforma móvil implementada. En cada una de las cuatro pistas diseñadas (representadas en la Tabla 2 con P1, P3 Y P4), se ejecutaron 5 pruebas de desempeño de la configuración de la plataforma. Así, tomando en cuenta la cantidad de obstáculos correspondientes a cada una de las pistas, se determinó la capacidad de la plataforma para evadirlos y de esta manera medir en términos porcentuales, la eficiencia y el error cometido por la plataforma en la determinación de la trayectoria.

Los principales resultados obtenidos reflejan que, cuatro de las cinco pruebas realizadas en cada una de las pistas (P1, P2, P3 y P4) tuvieron éxito total. Solamente en una de las pruebas la plataforma móvil diferencial falló en el reconocimiento de uno de los obstáculos diseñados. La explicación a este fenómeno se basa en que, durante la última prueba, la iluminación del ambiente presentó una falla por lo que el robot tuvo dificultad de procesar las imágenes capturadas con baja iluminación. Sin embargo, aunque es recomendable realizar más pruebas, estos primeros resultados son concluyentes respecto a la funcionalidad de la configuración implementada.

Tabla 2

Resultados de las pruebas de funcionamiento de la plataforma, ejecutadas sobre las 4 pistas diseñadas.

N° PRUEBA |

N° de obstáculos |

N° obstáculos evadidos |

Eficiencia |

Error |

Observación |

|||||||||||||||

P1 |

P2 |

P3 |

P4 |

P1 |

P2 |

P3 |

P4 |

P1 |

P2 |

P3 |

P4 |

P1 |

P2 |

P3 |

P4 |

P1 |

P2 |

P3 |

P4 |

|

1 |

2 |

2 |

3 |

3 |

2 |

2 |

3 |

3 |

100% |

100% |

100% |

100% |

0% |

0% |

0% |

0% |

- |

- |

- |

- |

2 |

2 |

2 |

3 |

3 |

2 |

2 |

3 |

3 |

100% |

100% |

100% |

100% |

0% |

0% |

0% |

0% |

- |

- |

- |

- |

3 |

2 |

2 |

3 |

3 |

2 |

2 |

3 |

3 |

100% |

100% |

100% |

100% |

0% |

0% |

0% |

0% |

- |

- |

- |

- |

4 |

2 |

2 |

3 |

3 |

1 |

1 |

3 |

3 |

50% |

50% |

100% |

100% |

50% |

50% |

0% |

0% |

DM |

DM |

- |

- |

5 |

2 |

2 |

3 |

3 |

2 |

2 |

1 |

1 |

100% |

100% |

33% |

33% |

0% |

0% |

67% |

67% |

- |

- |

DM |

DM |

*DM= Desbordamiento de la Matriz

Para apoyar o refutar la efectividad del sistema de control de la plataforma diseñada, se realizó la prueba de hipótesis aplicando Análisis de la Varianza a una cola (Montgomery, 2004). Así, para efectos de este estudio, se establecieron las siguientes hipótesis:

H0: El sistema de control visual y fusión sensorial sobre una plataforma móvil no permite la correcta navegación por interiores

H1: El sistema de control visual y fusión sensorial sobre una plataforma móvil permite la correcta navegación por interiores

De los datos obtenidos a través de las pruebas experimentales realizadas se extrajeron los necesarios para la aplicación de ANOVA, y son los contenidos en la Tabla 3

Tabla 3

Datos para la aplicación del estadístico ANOVA

DATOS |

Total de obstáculos evadidos |

Total de obstáculos No evadidos |

Eficiencia del sistema |

Pistas con 2 obstáculos |

18 |

2 |

8 |

Pistas con 3 obstáculos |

27 |

3 |

8 |

Según los datos obtenidos y basados en un nivel de significancia del 5%, con la aplicación del estadístico ANOVA se encuentra que el punto crítico tiene un valor de 9,55. El valor calculado de Fisher es de 15,62. Mediante la comparación entre estos dos valores se evidencia que el valor de Fisher se encuentra fuera de la región de aceptación, es decir, el punto crítico es menor que el valor calculado, por lo tanto, se rechaza la hipótesis nula y se acepta de forma plena la hipótesis alternativa, ratificándose que: “El sistema de control visual y fusión sensorial sobre una plataforma móvil permite la correcta navegación por interiores” .

En el presente trabajo se diseñó e implementó un sistema de control visual y fusión sensorial sobre una plataforma móvil para navegación de interiores. La estructura móvil diferencial fue desarrollada en base a los microcontroladores Raspberry Pi y Arduino Nano, comúnmente utilizados debido a las ventajas en cuanto a funcionalidades y costo que representan. Raspberry Pi se utilizó específicamente para el desarrollo del sistema de control visual mientras que Arduino fue empleado en el sistema de control diferencial.

El sistema de control visual implementado permitió la detección de obstáculos mediante la comparación de imágenes capturadas por la plataforma móvil y un conjunto de patrones almacenados en una base de datos. Con la implementación de un algoritmo de navegación, fue posible proporcionar una configuración adecuada que permitió la correcta toma de decisiones para el desplazamiento de la estructura móvil diferencial, la cual luego de procesar señales tomadas adquiridos por sensores ultrasónicos fue capaz de detectar la presencia de objetos, evitando chocar con éstos.

Durante las pruebas de funcionamiento, se evidenció que a pesar de que el sistema mostró tener un excelente desempeño en la detección y evasión de obstáculos; es susceptible a cometer errores producto de los cambios inesperados o no controlados en la iluminación del entorno.

El trabajo futuro se orienta a implementar mecanismo de reacción en la plataforma ante cambios en la iluminación, de tal forma que este factor externo no afecte el desempeño del sistema implementado. Además, con el fin de mejorar el proceso de toma de decisiones en la trayectoria de la plataforma móvil, se pretende implementar un proceso basado en técnicas de inteligencia artificial, mediante el cual el proceso de comparación de patrones tenga mejores tiempos de respuesta y permitan una mejor detección de objetos.

Barros Aragón, M. Á., Quinatoa, T., & Adrián, S. (2017). Construcción de un dispositivo de protección para motores trifásicos de inducción basado en el microcontrolador PIC(Bachelor's thesis, Quito, 2017.).

Bokade, A. U., & Ratnaparkhe, V. R. (2016, April). Video surveillance robot control using smartphone and Raspberry pi. In Communication and Signal Processing (ICCSP), 2016 International Conference on (pp. 2094-2097). IEEE.

Botero, J. D., Peña, C. A., & Mantilla, S. C. (2017). Implementación de robots animatrónicos para terapias motivadoras de rehabilitación física en niños. Revista ESPACIOS, 38(57).

Canny, J. (1986). A computational approach to edge detection. IEEE Transactions on pattern analysis and machine intelligence, (6), 679-698.

Casco, S. M. (2014). Raspberry Pi, Arduino y Beaglebone Black Comparación y Aplicaciones. Universidad Católica Nuestra Señora de la Asunción, Facultad de Ciencias y Tecnología.

Cianci, C. M., Raemy, X., Pugh, J., & Martinoli, A. (2006, September). Communication in a swarm of miniature robots: The e-puck as an educational tool for swarm robotics. In International Workshop on Swarm Robotics (pp. 103-115). Springer, Berlin, Heidelberg.

Jiang, N. (2016). Intelligent Stereo Camera Mobile Platform for Indoor Service Robot Research. Proceedings of the 2016 IEEE 20th International Conference on Computer Supported Cooperative Work in Desing, 5–9

Milena, A., López, L., Enrique, J., & Uribe, A. (2016). Visual servo control law design using 2D vision approach , for a 3 DOF robotic system built with LEGO EV3 and a Raspberry Pi, (v).

Mohamed, S., Mahmoud, T., & Ibrahim, M. (2017). Efficient edge detection technique based on hidden markov model using canny operator. threshold, 6(01).

Montgomery, D. (2004). Diseño y Análisis de Experimentos. LIMUSA WILEY (Vol. 2). http://doi.org/10.1016/S0141-3910(01)00005-2

Morris, K. J., Samonin, V., Anderson, J., Lau, M. C., & Baltes, J. (2018, June). Robot Magic: A Robust Interactive Humanoid Entertainment Robot. In International Conference on Industrial, Engineering and Other Applications of Applied Intelligent Systems (pp. 245-256). Springer, Cham.

Ollero, A. (2001). Robotica Manipuladores y robots moviles. Marcombo S.A.

Siciliano, B., Sciavicco, L., Villani, L., & Oriolo, G. (2009). Robotics Modelling, Planning and Control. http://doi.org/10.1007/978-1-84628-642-1

Tele, G. S., Kathalkar, A. P., Mahakalkar, S., Sahoo, B., & Dhamane, V. (2018). Detection of Fake Indian Currency. International Journal of Advance Research, Ideas and Innovations in Technology, 4(2), 170-176.

Vanitha, M., Selvalakshmi, M., & Selvarasu, R. (2016). Monitoring and controlling of mobile robot via internet through raspberry Pi board. 2016 2nd International Conference on Science Technology Engineering and Management, ICONSTEM 2016, 462–466. http://doi.org/10.1109/ICONSTEM.2016.7560864

Wilson, J. S. (2004). Sensor technology handbook. Elsevier.

1. Mag. Sistemas de control y automatización. Docente Facultad de Informática y Electrónica. Escuela Superior Politécnica de Chimborazo (ESPOCH). joseluis.tinajero@espoch.edu.ec

2. Mag. Ciencias de la Ingeniería Electrónica. Docente Facultad de Informática y Electrónica. Escuela Superior Politécnica de Chimborazo (ESPOCH). plozada@espoch.edu.ec

3. Ms. Automática y Robótica. Docente Facultad de Informática y Electrónica. Escuela Superior Politécnica de Chimborazo (ESPOCH). fausto.cabrera@espoch.edu.ec