Vol. 38 (Nº 30) Año 2017. Pág. 13

Vol. 38 (Nº 30) Año 2017. Pág. 13

PEÑATE, Yaimara 1; RIVERO, Jorge L. 2; LOZADA, Dayana I. 3;

Recibido: 05/03/2017 • Aprobado: 02/04/2017

2. Acercamiento al concepto de eficiencia en la Educación Superior

3. Evaluación de la eficiencia en universidades ecuatorianas

4. Aplicaciones del DEA en el ámbito universitario

RESUMEN: La preocupación por el uso eficiente de los recursos es un tema cada vez más presente en las agendas de las universidades, que ha demandado el desarrollo de técnicas específicas, dada las características propias de este tipo de institución. En este sentido, el objetivo de este trabajo fue desarrollar una exhaustiva revisión sobre las particularidades de la evaluación de la eficiencia en las universidades y demostrar la viabilidad y pertinencia del uso del Análisis Envolvente de Datos como técnica para su medición. |

ABSTRACT: Resources efficient use is a continual concern in universities agendas. This topic demand the development of specific techniques, due to the particularly characteristics of this institutions. The aim of this work was to develop an exhaustive review of the main particularities of the universities efficiency evaluation, to demonstrate the feasibility and pertinence of the Data Envelopment Analysis (DEA) as a university efficiency measurement technique. |

La actual revolución científico - técnica y la globalización de las economías han dado lugar al auge del conocimiento como un factor emergente decisivo para el éxito de varios países. Bajo este nuevo paradigma, donde el conocimiento y la información se convierten en los principales motores del desarrollo, la formación de capital humano avanzado, la investigación, el desarrollo y la innovación son un imperativo estratégico que deben asumir las Instituciones de Educación Superior (IES), como pilares fundamentales de la ventaja competitiva de los países y sus organizaciones.

En tal sentido, varios han sido los espacios donde se ha enfatizado reiteradamente que la pertinencia de la universidad en el siglo XXI se medirá, ante todo, por su capacidad transformadora para la conformación de un mundo mejor. Para poder servir a este cometido, actualmente las IES se enfrentan a un gran número de retos, entre los que se destacan: la masividad de la enseñanza, la pertinencia, el equilibrio entre las funciones básicas, la calidad, la administración eficiente y la internacionalización.

Al mismo tiempo, las universidades públicas, se desarrollan en un contexto de restricción de recursos donde deben competir con otras áreas del gasto público (sanidad, justicia, seguridad e incluso otros niveles educativos) así como, con todas las áreas de la actividad económica. A su vez, se encuentran expuestas a las continuas presiones financieras sobre el sector público, al aumento de las exigencias por parte de los usuarios para obtener mayores niveles de eficiencia y efectividad, a los cuales deben rendir cuenta; y a la gran inquietud social por dotar a los centros de decisión de las entidades públicas de modernas técnicas de gestión que contribuyan eficazmente al proceso de toma de decisiones.

Esta situación problémica exige a las universidades introducir cambios en sus sistemas de gestión con el objetivo de lograr un balance adecuado entre los roles y responsabilidades que se les ha encomendado, siendo necesario entre otros aspectos, evaluar sus recursos, procesos y resultados para: 1) mejorar su eficiencia, 2) agilizar y clarificar la rendición de cuentas, 3) avanzar en el conocimiento que se tiene de la rentabilidad económica y social de la inversión en educación, 4) realizar comparativas en horizontal –distintas universidades en los mismos ámbitos – y/o en vertical –diferentes servicios en una misma universidad – y 5) posibilitar el análisis de su impacto en la sociedad.

En este contexto, es donde la evaluación de la eficiencia en las IES cobra una gran importancia, generándose un incremento de los estudios sobre el tema en las últimas décadas (Gómez y Mancebón, 2012).

Al respecto, existe consenso entre los investigadores en que las características particulares y complejas que tienen los procesos en la Educación Superior, suponen dificultades para la estimación de la función de producción, y en consecuencia para la medición de la eficiencia en este sector. Situación que ha conducido en los últimos años al logro de importantes avances en el diseño y aplicación de instrumentos para tal fin, como es el Análisis Envolvente de Datos (DEA, por sus siglas en inglés), considerado como un método atractivo y ampliamente utilizado en las universidades del ámbito europeo.

No obstante, a nivel latinoamericano, puede decirse que este enfoque no ha sido ampliamente utilizado, y en el caso particular de las universidades ecuatorianas no se encontraron referencias en la literatura sobre su aplicación. Por lo que, este trabajo se propone realizar una revisión no exhaustiva, pero sí relevante, de las particularidades de la evaluación de la eficiencia en las universidades, las bases teóricas metodológicas que sustentan la técnica DEA y los resultados de su aplicación en varios ámbitos universitarios, con el fin de resaltar las potencialidades del uso de esta metodología para evaluar el grado de eficiencia con que las universidades ecuatorianas emplean sus recursos para satisfacer la oferta que proporcionan.

Desde el punto de vista microeconómico, el concepto de eficiencia relaciona los recursos empleados (inputs) por una unidad productiva con los resultados obtenidos (output). En este contexto, se dice que una unidad productiva es eficiente cuando se obtiene la máxima productividad de acuerdo con los recursos empleados o, alternativamente, cuando la cantidad utilizada de recursos para obtener un determinado nivel de producción sea mínima. Su esencia se encuentra en los procesos de optimización, siendo éstos centrales a todo el desarrollo económico.

En este sentido, para evaluar la eficiencia interna de cualquier organización es necesario construir, ya sea explícita o implícitamente según la técnica aplicada, una función de producción que refleje el proceso productivo mediante el cual las entidades objeto de valoración realizan la transformación de unos inputs en unos outputs (Gómez y Mancebón 2012).

En el ámbito de la Educación Superior, esta tarea puede hacerse compleja teniendo en cuenta las características que distinguen estas instituciones: 1) al ser organizaciones sin ánimo de lucro, se hace muy difícil estimar los precios de los insumos y las salidas debido a la complejidad de los procesos por su carácter psicopedagógico, y 2) las IES producen varias salidas de múltiples entradas, lo que supone dificultades para la estimación de la función de producción.

A la hora de especificar la función de producción de las IES, resulta útil tomar como punto de partida los objetivos que habitualmente se les atribuyen: formar profesionales altamente cualificados y ciudadanos responsables; constituir un espacio abierto para la formación superior que propicie el aprendizaje permanente; promover, generar y difundir conocimientos por medio de la investigación; contribuir a comprender, interpretar, preservar, reforzar, fomentar y difundir las culturas nacionales y regionales, internacionales e históricas (Declaración Mundial sobre la Educación Superior, 1998). La consecución de estos objetivos se obtiene a través del desarrollo de sus procesos fundamentales o claves: la docencia, la investigación y el desarrollo social o servicio público como también se les suele denominar.

Esta aproximación a la realidad productiva de las universidades pone de manifiesto una peculiaridad de su proceso de producción: la realización simultánea de dos actividades de distinta naturaleza. Por un lado, las universidades generan conocimientos a través de la investigación, y por otro, difunden sus conocimientos a través de la labor de docencia. Y lo que es también muy importante, muchos de los recursos empleados son compartidos por las dos actividades (profesorado, personal de administración y servicios, instalaciones, equipos, suministros, etc.). Esta particularidad necesariamente ha de condicionar todo el proceso de evaluación de su actividad y ha limitado la especificación de una función de producción generalmente aceptada en el sector de la ES.

En efecto para especificar una función de este tipo se hace necesario:

• Identificar y cuantificar los inputs y outputs relevantes, y

• Describir la relación entre esos inputs y outputs en términos matemáticos.

Atendiendo a la identificación de los inputs y outputs relevantes, dada las características de la Educación Superior son varias las dificultades que se pueden encontrar. Según Gómez y Mancebón (2005), quizás la más importante es la intangibilidad de muchas de sus características, que afecta tanto a los inputs (aspectos cualitativos de alumnos, profesorado, etc.), como a los outputs (valor añadido del conocimiento transferido, calidad de la investigación, etc.).

Es relevante señalar, que en el caso de los inputs el problema no se encuentra sólo en su selección y medición, aunque existan actualmente problemas con la disponibilidad de determinados datos y sobre todo con la medición de aspectos cualitativos de los mismos, sino también en el tratamiento que se le dé al tratarse de recursos compartidos (Gómez, 2005). Teniendo en cuenta estudios anteriores, se han recogido en el Anexo. 1 las variables inputs más utilizadas para evaluar la eficiencia en las universidades.

En relación a los outputs, habitualmente se utilizan indicadores de carácter cuantitativos para realizar una aproximación a estos, asociados a los procesos claves de las IES, el proceso docente, investigativo y el de servicios públicos (servicios a la comunidad y otras actividades).

La medición del output docente es el que más dificultades genera en los análisis a nivel institucional en la Educación Superior, ya que no existe acuerdo unánime acerca de qué indicadores emplear, entrando en juego dos dimensiones: el aprendizaje en sí mismo (output inmediato) y la inserción laboral que deriva de éste (output diferido). En el Anexo 2 se resumen las variables outputs más utilizadas para evaluar la eficiencia en las IES, según la literatura consultada.

Otra de las elecciones fundamentales en la evaluación de la eficiencia productiva tiene que ver con la metodología empleada para obtener las estimaciones (Gómez y Mancebón, 2012; Venegas, Rodríguez y Álvarez, 2014). En este sentido, las alternativas utilizadas son dos: métodos paramétricos, que fueron aplicados por los primeros estudios (Johnes y Taylor, 1990), a través de regresión de los mínimos cuadrados, y los métodos no paramétricos, que han sido utilizado por estudios más recientes a través de los métodos de frontera, como el DEA (Athanassopoulos y Shale, 1997; Abbott y Doucouliagos,2003; Johnes,2005, Cunha y Rocha, 2012; Ramírez y Alfaro, 2013; Nazarko y Saparauskas, 2014; Navarro y otros, 2016), o el análisis de la frontera estocástica (Izadi y otros, 2002).

El Análisis Envolvente de datos es una técnica, propuesta por Charnes, Cooper y Rhodes (1978), basada en la programación lineal, para medir el desempeño relativo de unidades de toma de decisión (DMUs por sus siglas en inglés). Para llevar a cabo las estimaciones de eficiencia se compara la actividad de cada una de las entidades objeto de evaluación con la de otras unidades productivas o DMUs, que, combinando los factores productivos de forma semejante, obtienen un mayor volumen de producción a partir de los mismos inputs (eficiencia en términos de output) o producen lo mismo utilizando menos recursos (eficiencia en términos de input).

La frontera de producción así construida representa una frontera factible y eficiente. Factible, porque al derivar de observaciones empíricas, refleja únicamente las prácticas de unidades productivas existentes. Eficiente, porque cada punto está definido exclusivamente en términos de las técnicas utilizadas por las unidades que representan las mejores prácticas.

En sentido general, el DEA es una técnica que evalúa cada entidad en comparación con un grupo de referencia que construye el propio método, formado por las entidades que siendo eficientes, más se parecen a aquellas cuya eficiencia se trata de valorar. Por tanto, considera que la ineficiencia técnica está presente en el comportamiento de alguna organización, si y sólo si, la evidencia indica que alguno de sus inputs u outputs puede ser mejorado sin empeorar ningún otro.

Atendiendo a las características de las IES, así como a las particularidades de cada uno de estos métodos, la revisión de la literatura se inclina por el DEA, como método más atractivo y ampliamente utilizado para la medición de la eficiencia de instituciones sin ánimo de lucro, como son las universidades. Su principal ventaja es su flexibilidad en cuanto a la modelización de la tecnología subyacente (Gómez y Mancebón, 2012; Navarro y otros, 2016, Cortés-Sánchez, 2016).

Existen otros argumentos que apoyan el empleo del DEA en este campo (Tabla 1), a pesar de que también se han señalado algunas debilidades, que deben ser consideradas para que no se afecten de forma importante los resultados de la evaluación que se esté efectuando.

Tabla 1. Ventajas y desventajas del DEA

VENTAJAS |

DESVENTAJAS |

|

|

Fuente: Elaboración propia

Otro elemento a considerar, cuando se trata de evaluar la eficiencia en universidades, es la selección de la técnica de evaluación no paramétrica más apropiada, teniendo en cuenta que se han utilizado una amplia gama de modelos. Algunos autores proponen el uso de los modelos envolventes de datos convencionales propuestos por Charnes, Cooper y Rhodes (1978), denominados Modelo CCR, o Banker, Charnes y Cooper (1984), denominados Modelos BCC, que fueron formulados al objeto de evaluar la actividad de organizaciones que llevan a cabo una actividad única.

En particular el modelo BBC, en comparación con el CCR, presenta algunas ventajas teniendo en cuenta que, como señalara Gómez (2005):

En el ámbito universitario estos modelos han sido utilizados, por una parte, sobre el conjunto de procesos desarrollados por las Universidades o departamentos, sin hacer ninguna diferenciación entre ellos. Cada universidad ha sido tratada como una entidad con una sola función de producción para ambos procesos, señalándose como deficiencia que se asume que las instituciones evaluadas son igualmente eficientes en todas sus tareas.

Por otra parte, otro grupo de investigaciones, que han basado sus estudios en evaluar la eficiencia a nivel de departamentos, aplican los modelos convencionales sobre un único proceso universitario, ya sea el de investigación, la docencia, o la vinculación con la sociedad, considerando independientes estas actividades. En este caso, la asignación arbitraria de los inputs a cada una de las actividades resta validez a sus resultados.

Para resolver los problemas antes mencionados, varios autores sugieren el modelo multiactividad como el que mejor se adapta a la Educación Superior, teniendo en cuenta que en el ámbito universitario se da la particularidad de la realización simultánea del proceso docente y el investigativo, utilizando una gran cantidad de recursos comunes. El

modelo multiactividad, diseñado por Beasley (1995) y desarrollado, en su versión dual, por Mar Molinero (1996) y Mar Molinero y Tsai (1997) permite distribuir objetivamente los recursos compartidos (profesorado, gastos corrientes, inversiones reales) entre los diferentes procesos, a la vez que permiten llevar a cabo un tratamiento individualizado de cada una de ellos (Gómez y Mancebón, 2012).

El atractivo de este modelo para evaluar la actividad productiva desempeñada por organizaciones, como las universidades, que realizan actividades muy diferentes empleando recursos comunes es, desde nuestro punto de vista, incuestionable. Por lo que, para un mejor entendimiento del mismo, a continuación, se detallan las características del modelo, teniendo en cuenta las alternativas que se pueden presentar.

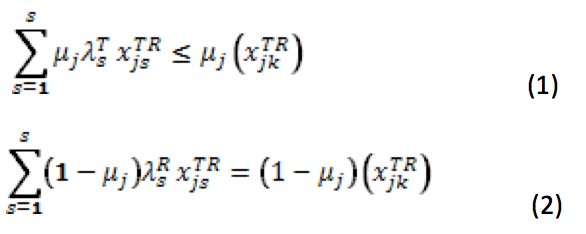

El objetivo del modelo multiactividad es maximizar conjuntamente las eficiencias de ambas actividades (ecuación 1), docencia (T) e investigación ®, teniendo en cuenta restricciones impuestas en dependencia de si los outputs e inputs están asociados de manera única a cada actividad o contribuyen de forma conjunta a las dos actividades.

![]()

Sujeto a:

En el caso de inputs/outputs compartidos cada input (output) que contribuya a ambas actividades generará dos restricciones en el modelo: en el caso de universidades, una que influirá en la determinación de la eficiencia del proceso docente y la otra que influirá en la determinación de la eficiencia del proceso investigador:

• Restricciones asociadas a la contribución de los inputs compartidos a la docencia e investigación:

• Restricciones asociadas a la contribución de los outputs compartidos a la docencia e investigación:

Además, se incluyen las restricciones comunes a los modelos convencionales:

Para desarrollar este modelo se deben tomar algunas decisiones por parte del investigador, en relación a la importancia que se le concede a cada actividad en el cálculo de la eficiencia global. Frecuentemente, se suele dar el mismo nivel de importancia a ambas actividades, teniendo en cuenta la complejidad que implica determinar qué actividad es más importante que otra y en qué medida.

Otra decisión importante, está relacionada con la distribución de los inputs compartidos, entre ambas actividades. En este caso, se recomienda realizarla en función de las horas promedio que dedican los docentes a cada actividad.

La Educación Superior en el Ecuador ha pasado por varias fases que comienzan desde el inicio de la vida republicana del país, donde fue concebida como el aprendizaje centrado en el alumno, con un analfabetismo acentuado y privilegio de pocos, hasta la creación del primer Consejo Nacional de Educación Superior (CES) en 1996, como impulsor para el crecimiento de instituciones públicas y privadas (Herrera y otros., 2015).

Aún con la creación del CES, continuó rigiendo en ecuador una educación tradicionalista, que no respondía a las necesidades sociales sino a las corrientes ideológicas de la época. No es hasta la entrada en vigencia de la Constitución Política del Ecuador en 1998, y la Ley Orgánica de Educación Superior (LOES), en el año 2000, que se comienza a sentar las bases para dar solución a la problemática de la Educación Superior, misma que se caracterizaba por una falta de orientación hacia el cliente y carencia de pertinencia de su oferta (Rojas 2011).

A partir de este momento, se observa un aumento del interés por la evaluación de la calidad del desempeño de las Instituciones de Educación Superior (IES), como uno de los elementos claves que determinan el posicionamiento estratégico de las universidades. Como resultado, teniendo en cuenta que la evaluación de la calidad es un proceso permanente y supone un seguimiento continuo, se creó el Consejo de Evaluación, Acreditación y Aseguramiento de la Calidad de la Educación Superior (CEAACES). El CEAACES ejerce por ley la rectoría de la política pública para el aseguramiento de la calidad de la educación superior del Ecuador a través de procesos de evaluación, acreditación y categorización en las IES (Asamblea Nacional del Ecuador, 2010)

En el Ecuador el sistema de educación superior, en su mayoría se encuentra compuesto por universidad públicas. De las 56 universidades y escuelas politécnicas que ofertan estudios de pregrado y postgrado, según datos del CEAACES (2015), el 53,57% son públicas, el 32,14 % son particulares autofinanciadas y el 14,28 % particulares que reciben rentas y asignaciones del Estado.

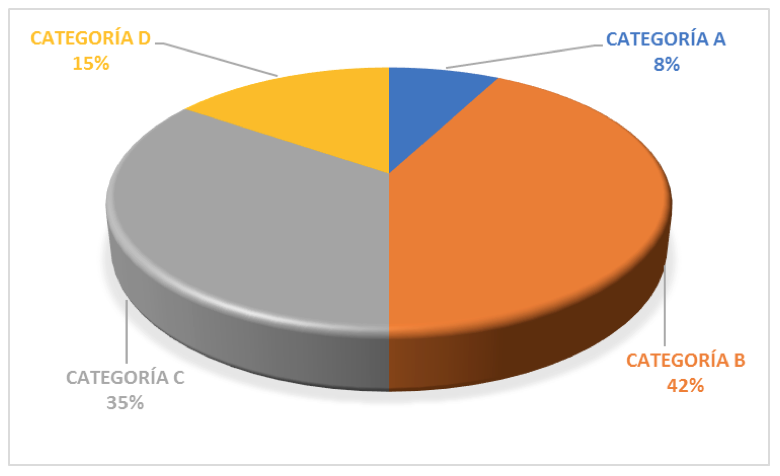

La puesta en marcha del CEAACES, ha tenido un gran impacto en el intento del gobierno por elevar los estándares de calidad de las IES ecuatorianas, mostrando evidencia de ello los diferentes informes emitidos que reflejan que de las 52 universidades que ofertan pregrado en el país, solo 4 universidades se encuentran en la categoría A, 22 se encuentran clasificadas en la categoría B, 18 universidades se ubican en la categoría C y 8 universidades en la categoría D (Figura 1), siendo, la A la de mejor desempeño y la D la de más bajo desempeño.

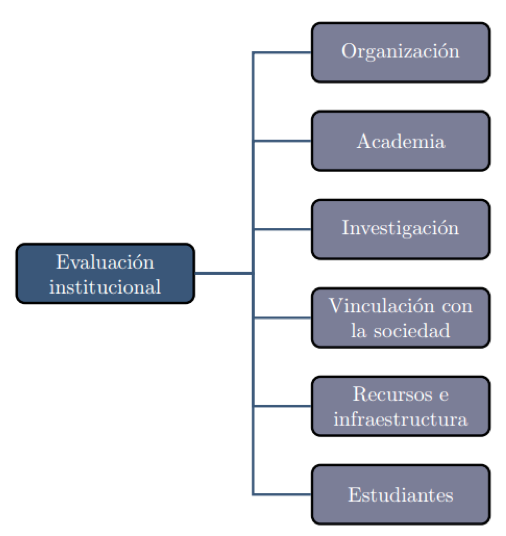

Este proceso de recategorización, utiliza estándares más rigurosos, poniendo especial énfasis en aspectos como la investigación, procesos académicos y actividades de gestión. Para el desarrollo del mismo se utiliza un modelo de evaluación institucional que aborda a las instituciones de educación superior como una unidad académica estructurada y funcional.

Figura 1. Distribución de universidades ecuatorianas por categoría

Fuente: Elaboración propia a partir de datos del CEACCES (2015)

La evaluación de las IES ecuatorianas se rige por los parámetros que establece el modelo de evaluación institucional del CEAACES. La concepción de este modelo de evaluación parte del concepto de calidad establecido en el sistema de educación superior ecuatoriano, donde la calidad se constituye en un principio que consiste en la búsqueda constante y sistemática de la excelencia, la pertinencia, producción óptima, transmisión del conocimiento y desarrollo del pensamiento mediante la autocrítica, la crítica externa y el mejoramiento permanente (LOES, 2010, art. 93).

Este modelo se estructura en cinco criterios que sirven de soporte para la articulación de los procesos académicos, la investigación y las actividades de gestión: academia, eficiencia académica, investigación, organización e infraestructura (Figura 2).

Figura 2. Criterios del Modelo de Evaluación Institucional de Universidades

Fuente: CEAACES, 2016

Para llevar a cabo el sistema de evaluación, el CEAACES utiliza un conjunto de técnicas para la recopilación de la información, como fichas técnicas, matrices de evaluación, formulario de verificación, así como técnicas para el análisis y el procesamiento de la información, entre las que se destaca el análisis multicriterio y el análisis de conglomerados a los resultados obtenidos por las instituciones en los respectivos modelos.

El análisis multicriterio permite evaluar el sistema de educación superior tomando en cuenta de forma integral todos los aspectos que contemplan a la realidad universitaria ecuatoriana. Complementando el análisis multicriterio, se utiliza el método de análisis directo para la clasificación de las IES, tomando en cuenta niveles mínimos de desempeño para cada categoría, cuya elección puede responder a consideraciones de carácter normativo. Por último, para visualizar las diferencias o semejanzas entre los grupos de universidades evaluadas, se utiliza el método de análisis de conglomerados donde se compara la distancia entre sus puntos globales, y se distinguen los diferentes grupos a través de un diagrama de árbol o dendograma.

Existen varios estudios relacionados con la aplicación del DEA en universidades, destacándose en este análisis investigaciones realizadas en Estados Unidos (Ahn at all., 1989; Cohn, Rhine and Santos, 1989; De Groot, McMahon and Volkwein, 1991; Nelson y Hevert, 1992; Dunbar and Lewis,1995 y King, 1997), en el Reino Unido (Johnes y Johnes,1995; Glass, McKillop y Hyndman, 1995; Athanassopoulos and Shale;1997), España (Pina y Torres, 1995; Martínez, 2000; Torrico, 2000; Gómez y Mancebón, 2005; Vázquez, 2007; Martí, Puerta y Calafa, 2009; García y Larrán, 2009; Gómez y mancebón, 2012); Australia (Abbot and Doucouliagos, 2003; Carrington et al. 2005); Italia (Agasisti y Johnes, 2008; Agasisti y Péres-Esparrel, 2009; Agasisti y Bonni, 2014)¸ Canadá (McMillan and Datta, 1998); Brasil (Marinho et al. 1997); Argentina (Alberto, 2005); Chile (Cáceres at all. 2013).

Analizando los diferentes estudios se denota que existen varios niveles de análisis a la hora de evaluar la eficiencia en IES, que van desde comparaciones que atienden a la universidad en su conjunto en un mismo país y entre países, hasta los que toman como unidad de decisión (DMU) a los departamentos y/o áreas del conocimiento entre varias universidades o en una misma universidad.

La mayoría de las investigaciones tratan de comparar distintas universidades dentro de un mismo país (Torrico et al, 2007), aunque existen algunos estudios que han realizado este análisis entre países, entre los cuales se puede citar, la comparación de 209 IES de 8 países Europeos, realizado por Joumady y Ris (2005), más recientemente, Agasisti y Johnes (2009), realizaron un estudio donde compararon la eficiencia técnica de universidades Inglesas e Italianas y de igual manera Agasisti y Pérez-Esparrell (2009), compararon IES italianas y españolas.

Entre las investigaciones que comparan distintas universidades dentro de un mismo país, unas aplicaciones estudian la eficiencia tomando como unidad de análisis a la propia universidad para obtener una jerarquía que sirva de guía a un estudiante para elegir una universidad (Sarrico et al. 1997); otras evalúan la efectividad del sistema universitario de un país a partir de los fondos públicos que se asignan (Avkiran, 2001; Abbot and Doucouliagos, 2003; Johnes, 2006; Fandel 2007; etc.).

Otros estudios evalúan también distintas universidades tomando como unidad de análisis a los departamentos dentro de un mismo país: Beasley (1990), compara los resultados para los departamentos de Química (52 departamentos) y Física (50 departamentos) en el Reino Unido. Pina y Torres (1995) estudian la eficiencia de 22 departamentos de contabilidad en la universidad española. En 1995 Johnes, G. y Johnes, J. aplicaron el DEA a los departamentos de economía del Reino Unido (36 departamentos). Sarafoglou y Haynes (1996) realizan su estudio para los departamentos de economía y empresa en 7 universidades suecas. En 1997 es evaluada la eficiencia en los departamentos de economía en 24 de las universidades australianas en el trabajo de Madden, Savage y Kemp y Martínez (2000) analiza la eficiencia técnica de los departamentos de análisis económico de las universidades españolas.

Mientras otros centran sus investigaciones en analizar la eficiencia de la labor docente y/o investigadora de los departamentos universitarios dentro de una misma universidad. Sinuay-Stern et. al. (1994), estudia los departamentos de la Universidad Ben-Gurion en Israel.; García y Gómez (1999) identifican los factores determinantes de la eficiencia en los 21 grupos de investigación de la Facultad de Ciencias de la Universidad de Cádiz en el periodo 1991-95; Torrico (2000), estudia cómo vincular la política de asignación de recursos financieros de una institución universitaria con el análisis de la eficiencia técnica de las 142 unidades funcionales que tenía la Universidad de Málaga en el curso 1997-98; Castrodeza y Peña (2002), analizan la eficiencia de la actividad investigadora de los 22 departamentos que integran el rama de conocimiento de las Ciencias Sociales y Jurídicas de la Universidad de Valladolid para el año 1999; Trillo (2002), estudia la eficiencia técnica de los 34 departamentos de la Universidad Politécnica de Catalunya en el periodo 1995-1999; Murias (2004); evalúa la eficiencia técnica de los 72 departamentos de la Universidad de Santiago de Compostela, contemplando su doble actividad docente e investigadora; Torrico et al, (2007) evalúan la eficiencia técnica de los 152 departamentos de la Universidad de Málaga y realizan un análisis contextualizado en cada una de las 5 ramas del cocimiento.

A partir de estas aplicaciones de DEA en la evaluación de la eficiencia en el sector universitario, pueden establecerse una serie de características generales. En primer lugar, la mayoría de los estudios se centran en comparar universidades dentro de un mismo país, comparando departamentos entre ellas o departamentos o áreas del conocimiento en una misma universidad.

Por otra parte, los estudios relacionados con aplicaciones a todos los niveles, en gran parte admiten que puede existir un problema de heterogeneidad al comparar unidades, ya sean universidades o departamentos, con características distintas. La solución más frecuente es dividir la muestra inicial de universidades o departamentos en grupos más homogéneos, bien sea en función de su experimentalidad o de la rama de conocimiento a la que pertenecen.

En cuanto al grado de experimentalidad o la rama de conocimiento, los resultados de gran parte de las investigaciones reflejan que estos son factores que influyen en los niveles de eficiencia tanto docente como investigativa de las universidades, incluso se encuentran evidencias de que la relación entre estas es inversamente proporcional.

En relación a los procesos claves seleccionados para evaluar la eficiencia, a nivel de departamentos, el proceso de investigación ha sido el más evaluado. El aspecto docente sólo aparece recogido en algunos de los trabajos, debido probablemente a la dificultad, y correspondiente controversia, que genera la medición del producto resultante de la docencia. Y en relación al proceso de vinculación, solo se encontró un estudio que tomase el mismo como referencia.

Asociado a los outputs, aunque muchos de los estudios reconocen la importancia de incluir la calidad del output, no es frecuente encontrar en los modelos variables que intenten reflejarla, especialmente en el caso de la docencia. En cuanto al aspecto investigador, suelen desglosarse los diversos productos, pero sólo en algunos casos se priorizan en función de su relación con la calidad de la investigación.

En otro orden, a modo general, existe consenso en la literatura en que los problemas de información existentes en las universidades condicionan la selección de inputs y outputs para desarrollar los estudios. Resultando paradójico que en una sociedad donde las nuevas tecnologías de la información y la comunicación han generado nuevas posibilidades en el manejo de los datos, una institución, como la universidad, sea tan parca en suministrar información útil acerca de sí misma.

La evaluación de la eficiencia en las universidades, y de modo particular en las IES ecuatorianas, responde a la necesidad que tienen las mismas de mejorar sus enfoques de gestión para poder enfrentar su entorno actual, caracterizado por la masividad de la enseñanza, reducción de los recursos financieros, materiales y humanos, y el aumento de las exigencias de los diferentes grupos de interés.

En este sentido, las características del sector educativo dificultan la especificación de una función de producción que facilite la evaluación de la eficiencia utilizando métodos tradicionales, lo que exige extremar las cautelas a la hora de llevar a cabo el proceso de selección de las variables representativas de la actividad universitaria y sobre las que se ha de fundamentar la evaluación de la eficiencia.

Particularmente, el modelo de evaluación utilizado por el CEAACES en Ecuador, resulta de gran utilidad para la medición del desempeño de las universidades ecuatorianas. No obstante, su alcance global resulta insuficiente para medir la eficiencia técnica de las IES, y poder evaluar de manera certera el uso que se está haciendo de los recursos en función del presupuesto asignado a las universidades públicas para su funcionamiento. Por tanto, se hace necesario el uso de otras técnicas que permitan cumplir este propósito.

En respuesta a lo anterior, en las últimas décadas se han observado importantes avances en el desarrollo de instrumentos y metodologías para medir la eficiencia en el ámbito universitario. Al respecto, dadas las características de los procesos de las IES, es recomendable el uso de técnicas no paramétricas. Especialmente el Análisis Envolvente de Datos (DEA), es el método que ha sido ampliamente utilizado en la literatura para la medición de la eficiencia en el ámbito universitario, debido a su flexibilidad en cuanto a la modelización de la tecnología subyacente.

Particularmente se recomienda el uso del modelo DEA multiactividad, debido a su superioridad sobre los modelos convencionales, a partir de su capacidad para asignar objetivamente los inputs compartidos a varias actividades y por suministrar tasas de eficiencia individualizadas para el proceso docente y el investigador, que son los que han sido utilizados como objeto de estudio en la mayoría de las investigaciones.

Existe una amplia evidencia a nivel internacional, tanto teórica como empírica, de la aplicación del DEA para medir la eficiencia en el sector universitario. Los resultados obtenidos por las diferentes investigaciones demuestran la pertinencia y viabilidad del uso de esta tecnología para tal fin, con independencia del ámbito geográfico y de las características económico-sociales de las universidades.

A partir de la revisión realizada se evidencia las potencialidades significativas de generalización, en el corto plazo, del Análisis Envolvente de Datos como técnica para evaluar la eficiencia en el proceso docente y el investigador en el contexto universitario ecuatoriano. Y en un futuro cercano, sería conveniente desarrollar investigaciones que amplíen su campo de acción e incluyan en sus estudios la evaluación de la eficiencia del proceso de vinculación con la sociedad. Tema que se considera aún como tarea pendiente en esta área de investigación.

Abbott, M., y Doucouliagos, C. (2003). The efficiency of Australian universities: A Data Envelopment Analysis. Economics of Education Review, 22, 89-97.

Agasisti, T., y Bonomi, F. (2014). Benchmarking universities' efficiency indicators in the presence of internal heterogeneity. Studies in Higher Education, 39(7), 1237-1255.

Agasisti, T., y Johnes, G. (2008). Heterogeneity and the evaluation of efficiency: the case of Italian universities. Applied Economics, 1-11.

Agasisti, T. y Pérez-Esparrel, C. (2009): Comparing efficiency in a cross-country perspective: the case of Italian and Spanish state universities. Journal of Higher Education, 59, 85-103.

Ahn, T., Charnes, A. y Cooper, W.W. (1988). Efficiency characterizations in different DEA models. Socio-Economic Planning Sciences, 22(6), 253-257.

Athanassopoulos, A. D. y Shale, E. (1997). Assessing the Comparative Efficiency of Higher Education Institutions in the UK by Means of Data Envelopment Analysis. Education Economics, 5(2), 117- 134.

Avkiran, N. K. (2001). Investigating technical and scale efficiencies of Australian universities through Data Envelopment Analysis. Socio-Economic Planning Sciences, 35, 57–80.

Beasley, J. E. (1995). Determining Teaching and Research Efficiencies. Journal of the Operational Research Society, 46, 441-452.

Castrodeza, C. y Peña, T. (2002). Evaluación de la actividad investigadora universitaria: una aplicación a la universidad de Valladolid. Estudios de Economía Aplicada, 20(1), 29-44.

Cooper, W. W., Seiford, L. M. y Zhu, J. (ed.) (2004). Handbook on Data Envelopment Analysis, citado en el texto (International Series in Operations Research and Management Science, 71, Boston, EE. UU).

Cortés-Sánchez, J.D. (2016). Eficiencia en el uso de bases de datos digitales para la producción científica en universidades de Colombia. Revista Española de Documentación Científica, 39(2), e130

Charnes, A., Cooper, W. W. y Rhodes, E. (1978). Measuring the Efficiency of Decision Making Units. European Journal of Operational Research, 429-444.

Emrouznejad, A., Banker, R., Lopes, A. L. M., y de Almeida, M. R. (2014). Data envelopment analysis in the public sector. Socio-economic planning sciences, 48(1), 2-3.

Fandel, G. (2007). On the performance of universities in North Rhine-Westphalia, Germany: government’s redistribution of funds judged using DEA efficiency measures. European Journal of Operational Research, 176, 521–533.

Farrell, M. J. (1957). The Measurement of Productive Efficiency. Journal of the Royal Statistical Society, Series A, 120, 253-290.

García Valderrama, T. y Gómez Aguilar, N. (1999). Factores determinantes de la eficiencia de los grupos de investigación en la Universidad. Hacienda Pública Española, 148, 131-145

Giménez García, V. M. (2000). Eficiencia en costes y calidad en la universidad. Una aplicación a los departamentos de la UAB. (Tesis de doctorado). Universitat Autónoma de Barcelona. España

Gómez Sancho, J. M. (2005). La evaluación de la eficiencia productiva de las Universidades Públicas Españolas. (Tesis de doctorado). Universidad de Zaragoza. España

Gómez Sancho, J. M. y Mancebón, M. J. (2005). Algunas reflexiones metodológicas sobre la evaluación de la eficiencia productiva de las instituciones de educación superior. Ekonomiaz, 1(3), 60

Hanke, M. y Leopoldserder, T. (1998). Comparing the Efficiency of Austrian Universities: A Data Envelopment Analysis Application. Tertiary Education and Management, 4(3), 191-197.

Herrera, L. A. B., Gonzales, E. M. F., Jaramillo, N. D. G., Simbaña, R. M. J., & Ulloa, M. N. O. (2015). La educación superior y el proceso de transformación social en el ecuador. Quipukamayoc, 22(42), 187-200

Johnes, G., Johnes, J., Lenton P., Thanassoulis E. y Emrouznejad, A. (2005). An exploratory analysis of the cost structure of higher education in England. London, UK: Department for Education and Skills (DES).

Mar Molinero, C. (1996). On the Joint Determination of Efficiencies in a Data Envelopment Analysis Context. Journal of the Operational Research Society, 47, 1273-1279.

Mar Molinero, C. y Tsai, P. F. (1997). Some mathematical properties of a DEA model for the joint determination of efficiencies. Journal of the Operational Research Society, 48, 51-56.

Navarro Chávez, José César Lenin; Gómez Monge, Rodrigo; Torres Hernández, Zacarías; (2016). Las universidades en México: una medida de su eficiencia a través del análisis de la envolvente de datos con bootstrap. Acta Universitaria, Noviembre-Diciembre, 60-69

Nigsch, S., y Schenker-Wicki, A. (2015). Frontier efficiency analysis in higher education. In Incentives and Performance (pp. 155-170). Springer International Publishing.

Reshadi, M. (2013). Ranking in DEA Using Different Efficiency Levels. Journal of Basic and Applied Scientific Research, 3(2s), 156-162

Rodríguez Ponce, E. (2009). El rol de las universidades en la sociedad del conocimiento y en la era de la globalización: Evidencia desde Chile. Revista Interciencia, 34, 822-829.

Rojas, J. E. (2011). Reforma universitaria en el Ecuador. Etapa de transición. Innovación Educativa, 11(57), 59-67.

Taylor, B. y Harris, G. (2004). Relative efficiency among South African universities: A Data Envelopment Analysis. Higher Education, 47, 73–89.

Trillo del Pozo, D. (2002). La función de distancia: Un análisis de la eficiencia en la universidad (Tesis de Doctorado). Universidad Rey Juan Carlos. España

Tsai, P. F. y Mar Molinero, C. (2002). A variable return to scale data envelopment analysis model for the joint determination of efficiencies with an example of the UK health service. European Journal of Operational Research, 141, 21- 38.

Ulutas, B. H. (2011). Assessing the Relative Performance of University departments: teaching vs. Research. Ekonometri ve Istatistik e-Dergisi, 13, 125-138.

Venegas, H. C., Rodríguez, W. K., y Álvarez, J. T. (2014). Análisis de la eficiencia técnica y su relación con los resultados de la evaluación de desempeño en una Universidad Chilena. Innovar: Revista de ciencias administrativas y sociales, 24(54), 199-217.

ANEXO 1. Variables inputs utilizadas en estudios sobre

evaluación de la eficiencia en la Educación Superior

VARIABLES INPUTS |

TRABAJOS EN EL QUE APARECEN |

Recursos Humanos |

|

Matriculados en cursos para no graduados (ETC) |

Anh (1987); Ahn, Chames y Cooper (1988); Athanassopoulos y Shale (1997). |

Matriculados en cursos de postgrados (ETC) |

Anh (1987); Ahn, Chames y Cooper (1988); Athanassopoulos y Shale (1997). |

Número total de alumnos. |

Marinho, Resende y Façanhn (1997); Hanke y Leopoldseder (1998); Taylor y Harris (2004); Agasisti y Pérez-Esparrells (2009); Agasiti y Johnes (2009). |

Personal de apoyo y categoría. |

Marinho, Resende y Façanhn (1997); Li y Ng (2000);Abbot y Doucouliagos (2003); Agasisti y Pérez-Esparrells (2009). |

Número de profesores a tiempo completo y equivalentes a tiempo completo (ETC) |

Rhodes y Southwick (1993); Avrikan (2001); Abbot y Doucouliagos (2003); Taylor y Harris (2004); Gómez Sancho (2005); Tomkins y Green (1988), Pina y Torres (1995); Olesen y Petersen (1995). |

Número de profesores asociados |

Rhodes y Southwick (1993) |

Profesorado: doctor y no doctor, con y sin grado de especialización. |

Marinho, Resende y Façanhn (1997); Agasisti y Pérez-Esparrells (2009); Agasiti y Johnes (2009). |

Número de investigadores |

Li y Ng (2000), |

Profesores dedicados a la enseñanza e investigación en personas/mes. |

Johnes y Johnes (1993, 1995). |

Profesores dedicados a la investigación a tiempo parcial. |

Pina y Torres (1995); Doyle y Green (1996). |

Personal docente e investigador |

Trillo del Pozo (2002); Johnes (2006). |

Gastos |

|

Gastos anuales en mantenimiento |

Rhodes y Southwick (1993); Gómez Sancho (2005); |

Gastos anuales en actividades de biblioteca. |

Rhodes y Southwick (1993); Johnes (2006). |

Gastos generales e ingresos por investigación. |

Athanassopoulos y Shale (1997).Beasley (1990, 1995). |

Gastos totales excepto salarios |

Hanke y Leopoldseder (1998); Abbot y Doucouliagos (2003); Johnes (2006). |

Salarios |

Hanke y Leopoldseder (1998); Tomkins y Green (1988); Sinuai-Sterm, Mherez y Marboy (1994) |

Gastos totales |

Tomkins y Green (1988); Beasley (1990, 1995). |

Gastos por equipamiento |

Beasley (1990, 1995). |

Fondos de investigación pércapita |

Johnes y Johnes (1993) |

Gastos en la adquisición de libros y revistas por profesor. |

Pina y Torres (1995); |

Recursos financieros propios |

Agasisti y Pérez-Esparrells (2009) |

Total, de ingresos/ recursos financieros |

Agasiti y Johnes (2009). |

Fuente: Adaptado de Gómez y Mancebón (2005)

-----

ANEXO 2. Variables outputs utilizadas en estudios

sobre evaluación de la eficiencia en la Educación Superior

VARIABLES OUTPUT |

TRABAJOS EN EL QUE APARECEN |

Asociados a la docencia |

|

Matriculados en cursos para no graduados |

Anh (1987); Ahn, Chames y Cooper (1988) |

Matriculados en cursos de postgrados |

Rhodes y Southwick (1993); Avrikan (2001); Abbot y Doucouliagos (2003); Beasley (1990); Pina y Torres (1995) |

Títulos de grado concedidos |

Rhodes y Southwick (1993); Marinho, Resende y Façanha, 1997; Avrikan (2001); Abbot y Doucouliagos (2003); Tomkins y Green (1988). |

Créditos obtenidos por los estudiantes graduados |

Taylor y Harris (2004). |

Indicador de calidad de la docencia |

Trillo del Pozo (2002). |

Títulos de máster concedidos |

Rhodes y Southwick (1993); Marinho, Resende y Façanha (1997); Athanassopoulos y Shale (1997); Abbot y Doucouliagos (2003); Gómez Sancho (2005); Johnes (2006); Agasisti y Johnes (2009). |

Proporción de alumnos con mejores notas |

Sarrico (1997). |

Asociados a la investigación. |

|

Títulos de doctorados concedidos |

Rhodes y Southwick (1993); Marinho, Resende y Façanha (1997); Athanassopoulos y Shale (1997); Gómez Sancho (2005). |

Evaluación institucional de la investigación |

Athanassopoulos y Shale (1997); Beasley (1995). |

Número de publicaciones |

Hanke y Leopoldseder (1998); Li y Ng (2000); Tomkins y Green (1988); Sinuai-Sterm, Mherez y Marboy (1994); Agasisti y Pérez-Esparrells (2009) |

Número de premios |

Li y Ng (2000); |

Ingresos por investigación |

Tomkins y Green (1988); Beasley (1990, 1995) |

Artículos en revistas académicas |

Johnes y Johnes (1993; Pina y Torres (1995); Doyle y Green (1996). |

Libros |

Johnes y Johnes (1993); Olesen y Petersen (1995); Doyle y Green (1996). |

Fondos de investigación |

Johnes y Johnes (1993); Sinuai-Sterm, Mherez y Marboy (1994); Doyle y Green (1996); Agasisti y Pérez-Esparrells (2009). |

Becas dirigidas a investigación |

Doyle y Green (1996). |

Publicaciones en revistas notables ponderadas por factor de impacto o por calidad |

Trillo del Pozo (2002); Gómez Sancho (2005); |

Ingresos a partir de proyectos |

Trillo del Pozo (2002); Torrico et al (2009). |

Patentes y consultorías a organizaciones públicas y privadas. |

Agasisti y Pérez-Esparrells (2009) |

Compartido por ambos |

|

Gastos generales |

Anh (1987); Ahn, Chames y Cooper (1988) |

Gastos de biblioteca |

Sarrico (1997). |

Fuente: Adaptado de Gómez y Mancebón (2005)

1. PhD en Administración de Empresas. Facultad de Ciencias Administrativas. Universidad de Guayaquil. yaimara.penates@ug.edu.ec

2. PhD Student. Universidad de Coimbra. jlrivero85@gmail.com

3. PhD en Ciencias Económicas y Empresariales. Facultad de Ciencias Administrativas. Universidad de Guayaquil. dayana.lozadan@ug.edu.ec