![]() Espacios. Vol. 36 (Nº 21) Año 2015. Pág. E-4

Espacios. Vol. 36 (Nº 21) Año 2015. Pág. E-4

Pós-Graduação Strictu Sensu no Brazil: Análise de uma Universidade Privada

Graduate Stricto Sensu in Brazil: Analysis of a Private University

Priscilla Veiga BUENO 1; Daniela Torres da ROCHA 2; Claudimar Pereira da VEIGA 3; Luiz Carlos DUCLÓS 4

Recibido: 12/07/2015 • Aprobado: 10/08/2015

Contenido

4. Apresentação e análise dos resultados

5. Considerações finais e sugestões de pesquisa futura

RESUMO: O objetivo deste artigo é avaliar a eficiência de oito programas de mestrado de uma Universidade privada localizada no Sul do Brasil, por meio da aplicação da Data Envelopment Analysis (DEA). Por fim, foram selecionadas cinco variáveis de recursos: (i) número total de docentes, (ii) número de docentes permanentes no programa, (iii) número de linhas de pesquisa no programa, (iv) número de projetos de pesquisa no programa e, por fim, (v) número de disciplinas ofertadas, além de quatro variáveis de resultados. Os resultados indicam que 94% da amostra apresenta dificuldade para aproveitar os recursos disponíveis de forma eficiente, com indícios do comprometimento da qualidade dos programas de mestrado. |

ABSTRACT: The purpose of this article is to evaluate the efficiency of eight master's programs in a private university located in southern Brazil, through the application of Data Envelopment Analysis (DEA). Five variables were selected: (i) total number of teachers, (ii) number of permanent teachers in the program, (iii) number of lines of research in the program, (iv) number of research projects in the program, (v) number of offered subjects and four variable results. The results indicate that 94% of the sample has difficulty to take advantage of the available resources efficiently, which demonstrates commitment of the evidence of the quality of master's programs. |

1. Introdução

A Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (CAPES), criada em 1951, tem o objetivo de garantir pessoal qualificado em nível superior para atendimento às demandas de educação e desenvolvimento científico no Brasil, tem sido o principal agente de regulação e de orientação ao desenvolvimento dos programas de pós-graduação nacionais. Desde 1976, quando implantou o Sistema Nacional de Avaliação dos cursos de pós-graduação é considerada como a principal referência para a elaboração de estratégias de desenvolvimento desses programas. Os Programas de Pós Graduação Stricto Sensu no Brasil, desde então, têm desenvolvido suas políticas de aperfeiçoamento a partir do que propõem os critérios de qualidade definidos pelo sistema (Neves, Costa, 2006; Fernandes et. al. 2015).

Como único referencial de avaliação, a CAPES, disposto no país para regular a qualidade da oferta em nível de pós-graduação e mesmo com a adoção, conforme observam Neves e Costa (2006 p.1): "estratégias ancoradas e articuladas com o desenvolvimento nacional", suas ações não têm disposto de instrumental adequado que permita, de fato, avaliar a produtividade e eficiência desses programas, tampouco lhes auxilia com presteza no desenvolvimento de estratégias consistentes de promoção. Indicadores de infra-estrutura do programa, tais como: (i) quantidade e nível de formação docente, (ii) projeto pedagógico e proposta do programa, (iii) instalações, (iv) variedade de linhas e (v) projetos de pesquisa. Outros elementos de promoção das atividades de pesquisa e formação em nível de pós-graduação, têm sido empregados para avaliar a qualidade dos programas, mas também, têm sido equivocadamente associados a indicadores de desempenho e usados para a diferenciação dos programas no tocante à eficiência, mesmo que, de fato, não seja mensurada.

O objetivo do presente trabalho não é avaliar os acertos de uma gestão acadêmica, muitas vezes contrabalanceados por seus muitos erros, nem vice-versa. É difícil construir uma crítica baseada na postura histórica de facilitar o desenvolvimento de tecnologias e ferramentas que dão suporte às universidades, principalmente quando o funcionamento eficiente destas afeta o interesse e o bem-estar publico (Veiga et. al. 2014). Neste sentido, o presente estudo tem como objetivo avaliar a eficiência dos programas de Stricto Sensu de uma Universidade privada localizada na região Sul do Brasil.

Com esse propósito, além da parte introdutória, o presente trabalho encontra-se estruturado nas seguintes seções: (i) Referencial Teórico; (ii) Material e método; (iii) Apresentação e análise dos resultados e, por fim, (iv) as considerações finais e sugestões de pesquisa futura.

2. Referencial Teórico

A implantação de sistemas de avaliação de pós-graduação não é um fenômeno somente brasileiro, ela surgiu e se fortaleceu de diferentes formas e com graus variados de abrangência em diversos países (Durham,1992; Yang et. al. 2011). No Brasil, essas avaliações começaram a acontecer em 1976, com a criação do Sistema Nacional de Avaliação dos cursos de pós-graduação, concebido e implantado pela CAPES, órgão vinculado ao Ministério da Educação e do Desporto (MEC). Os objetivos inicialmente declarados para justificar a concepção e adoção do sistema de avaliação dos cursos de pós-graduação eram os seguintes: (i) facilitar a distribuição de bolsas de estudo para mestrandos e doutorandos e orientar o investimento das agências federais na formação de recursos humanos de alto nível; (ii) subsidiar a política educacional relativa à pós-graduação e à universidade; (iii) além de criar um sistema permanente de informações sobre a pós-graduação brasileira. Todavia, de acordo com o INFOCAPES (1996) pelo menos outros dois objetivos devem ser somados àqueles oficialmente declarados: (i) regular a expansão da pós-graduação, recomendando o apoio aos cursos novos e incorporando-os progressivamente ao sistema de avaliação e acompanhamento; e (ii) credenciar esses cursos, tornando válidos, em plano nacional, os certificados por eles expedidos.

Quando o sistema de avaliação da pós-graduação foi implantado, inicialmente, houve a decisão de que a sua sistemática se orientaria pelos resultados alcançados, o que permitiria se efetuar o processamento dos dados coletados. No qual, anualmente, relatórios detalhados sobre os programas e cursos avaliados eram elaborados, e os dados reunidos eram processados pela CAPES e analisados pelos membros dascomissões de especialistasformadas para este fim. Todavia, com a preocupação de aprofundar a análise dos dados disponibilizados anualmente pelos programas avaliados, em 1980, a sistemática foi aperfeiçoada na medida em que foram incorporadas visitas in loco, realizadas a cada dois anos por consultores ad hoc, designados pela CAPES (Gatti, 2000).

Os programas de pós-graduação vêm sendo avaliados no Brasil quase que exclusivamente sob o prisma da qualidade científica necessária para consolidar o ensino de pós-graduação no Brasil, embora a legislação atribua ao MEC a tarefa de realizar avaliação das Instituições de Ensino Superior (IES) de modo direcionado aos fatores que determinam a qualidade e a eficiência das atividades de ensino, pesquisa e extensão. De acordo com o autor, tal ocorrência se dá devido ao fato dos resultados da avaliação corrente promovida pela CAPES, embora prioritariamente destinada à classificação de programas de ensino de pós-graduação com vistas à alocação de recursos para consolidação desse nível de ensino, estejam sendo empregados também para o credenciamento e recredenciamento desses programas e, pelas próprias instituições de ensino superior que os abrigam, para orientar a implantação e o aperfeiçoamento de seus cursos de pós-graduação (Paiva, 2000).

As formas atualmente empregadas para avaliar o desempenho de programas de pós-graduação têm se baseado em aferições condicionadas a padrões pré-fixados pelas agências e instituições que os avaliam que impedem o conhecimento real da eficiência potencial existente no grupo e as peculiaridades que contemplam. Isso tem provocado certa homogeneidade aparente entre os programas e uma impaciente busca pelo alcance de conceitos ao invés de resultados qualitativos reais para esses programas. Além disso, nessas condições, a produtividade do programa se revela como produção quantitativa de publicações nos canais avaliados como válidos pelos formuladores dos padrões de avaliação da CAPES e a eficiência se torna sinônimo de alcance desses padrões, consequentemente dos conceitos mais elevados, e não de emprego inteligente e diferenciado dos recursos detidos para essa produção, tampouco de alcance de notoriedade e efeito público daquilo que produzem, que era de se esperar (Moita, 2002).

2.1. Sistema de Avaliação da Capes

A CAPES, nas últimas décadas, vem desenvolvendo seu sistema de avaliação por meio de um conjunto de concepções, definições e procedimentos, que podem ser considerados como padrão de referência, tanto internamente quanto para o exterior. Seu valor ganha destaque diante das poucas políticas governamentais direcionadas à Educação e aos seus aspectos de regularidade, abrangência e permanência (Oliveira, Mello, 2006). Este sistema, utilizado para avaliação dos programas de pós-graduação brasileiros, é o mesmo para todas as áreas, sendo que a CAPES adota cinco critérios de avaliação e cada um tem peso diferente na composição da nota final, conforme mostrado no Quadro 1.

Proposta do programa |

Este critério é qualitativo e não possui peso na avaliação, esta é interpretada como adequada ou inadequada. É neste critério que os programas descrevem suas área(s) de concentração, linhas de pesquisa e projetos em andamento. Neste item também se verifica a coerência, consistência e abrangência da estrutura curricular, a infraestrutura para ensino, pesquisa e extensão e as atividades de formação de docentes. |

Corpo docente |

É composto pelos seguintes itens: formação dos docentes permanentes; adequação da dimensão, composição e dedicação dos docentes permanentes; perfil do corpo permanente em relação à proposta do programa; atividade docente permanente na pós-graduação; Atividade docente permanente na graduação; participação dos docentes em pesquisa e desenvolvimento de projetos. |

Corpo discente |

Os seguintes itens o compõem: percentual de defesas mestrado/doutorado em relação ao corpo docente permanente; adequação e compatibilidade da relação orientador/discente; participação de discentes autores da pós-graduação e graduação; dissertações/teses vinculadas a publicações; qualidade das teses e dissertações; tempo médio de titulação de mestres e doutores. |

Produção intelectual |

Esse critério é composto pelos itens: publicações qualificadas do programa por docente permanente; distribuição de publicações qualificadas em relação ao corpo docente permanente; produção técnica ou tecnológica; produção de alto impacto. |

Inserção social |

É composto pelos seguintes itens: inserção e impacto regional e/ou nacional do programa; integração e cooperação com outros programas; e visibilidade e transparência do programa (CAPES, 2010). |

Quadro 1 - cinco critérios de avaliação CAPES

Fonte: CAPES (2010)

3. Material e método

Esta pesquisa pode ser caracterizada como um estudo descritivo (Gil, 2002), permitindo apenas conhecer o fenômeno explorado e não explicar as razões para os eventos e relações encontradas. Em relação ao delineamento, trata-se de um levantamento, de caráter quantitativo. Em função do tempo de coleta e aplicação, o trabalho pode ser visto como um estudo de corte transversal porque envolve medições do desempenho dos programas por meio da análise das características de uma amostra fixa da população no triênio 2007 a 2009 pela observação do relatório final de avaliação da CAPES.

3.1 População e amostra

Como objetivo de pesquisa, a Instituição de Ensino Superior (IES), em 2013, demanda 13 programas de pós-graduação Stricto Sensu, divididos em nível de mestrado, mestrado profissional e doutorado. Para o desenvolvimento deste estudo, foram considerados todos os programas de mestrado avaliados pela CAPES no triênio 2007-2009, sendo excluídos desta forma os programas de Engenharia Florestal, Saúde Coletiva e o curso de mestrado profissional Ensino de Ciências Naturais e Matemática, resultando em um total de 8 programas analisados, o que equivale a todos os casos disponíveis nesta instituição. Os programas estudados são: (i) Administração; (ii) Ciências Contábeis; (iii) Desenvolvimento Regional; (iv) Educação; (v) Engenharia Ambiental; (vi) Engenharia Elétrica; e por fim, (vii) Engenharia Química e Química.

3.2. Coleta dos dados

Foram coletadas informações de uma amostra de dados organizados pelo sistema DATACAPES a partir das avaliações realizadas no triênio 2007-2009 para cada um dos programas de mestrado pesquisados, cujos dados foram obtidos junto ao banco de dados da CAPES.

3.3. Métricas de análise e definição das variáveis

Foi utilizado na análise descritiva dos dados o pacote estatístico SPSS, no qual foi possível a caracterização da amostra. Já para a análise da eficiência, objetivo principal do estudo, foi utilizada a métrica denominada de Data Envelopment Analysis (DEA) por meio de planilha eletrônica Excel.

O método DEA ou Análise Envoltória dos Dados, em comparação com os instrumentos convencionais, representa uma das mais adequadas ferramentas para avaliar a eficiência. Seus resultados são mais detalhados do que os obtidos em outras abordagens, servindo melhor ao embasamento de recomendações de natureza gerencial (Zhu, 2000; Liu et al., 2016).

Apesar de originalmente ser uma metodologia proposta em um ambiente de produção, a DEA pode ser utilizada como um método multicritério, quando utiliza indicadores do tipo: (i) quanto menor melhor no lugar dos recursos e do tipo (ii) quanto maior melhor no lugar dos resultados. Isso transforma a DEA em um método de Apoio Multicritério à Decisão (AMD), aplicado com o intuito de consolidar várias perspectivas com base nos critérios de desempenhos diferentes (Souza, Macedo, 2009; Yang et. al. 2015). O objetivo dessa métrica é verificar se unidades produtivas operam de maneira adequada quando observada a relação entre uma lista específica de recursos utilizados e de resultados obtidos em unidades consideradas similares por seus administradores, sem a necessidade de conhecer, a priori, qualquer relação de importância dos pesos entre as variáveis consideradas (Belloni, 2000).

DEA é uma técnica não-paramétrica que emprega programação matemática para construir fronteiras de produção de unidades produtivas – DMU's que empregam processos tecnológicos semelhantes para transformar múltiplos insumos em múltiplos produtos. As fronteiras de eficiência criadas pelo modelo são empregadas para avaliar a eficiência relativa dos planos de operação executados pelas DMU's, servindo também como referência para o estabelecimento de metas eficientes para cada uma delas. Tem como principal finalidade estimar as eficiências dos planos de operação executados por unidades produtivas homogêneas, que usam um mesmo conjunto de recursos para produzir um mesmo conjunto de resultados, por meio de processos tecnológicos similares (Beckenkamp, 2002; Belloni, 2000).

Para avaliar a eficiência de organizações cujas atividades não visam lucros ou para as quais não existem preços pré-fixados para todos os insumos ou todos os produtos, o método DEA é apropriado. Como não há preços que estipulem pesos e restrições à combinação dos fatores, a identificação das taxas de substituição entre insumos e das taxas de troca entre produtos fica prejudicada e, diante disso, o método promove a identificação dos pesos multiplicadores relativos ao conjunto de DMU's avaliadas. Desse modo, as taxas de substituição e as taxas de troca acabam não sendo as mesmas para todas as unidades produtivas (Beckenkamp, 2002; Lapa, Neiva, 1996; Paiva, 2000). Afirmam os autores Lapa e Neiva (1996), que tais características tornam o método DEA próprio para a realização de avaliação institucional de universidades públicas e privadas, bem como de unidades acadêmicas, como centros de ensino e de pesquisa.

A utilização de DEA para o cálculo da eficiência relativa de programas ou de universidades requer como referência um conjunto de outros programas com proposta e recursos similares (Moita, 2002; Liu et. al. 2016). Isso ocorre porque o DEA traça uma curva de eficiência a partir da eficiência do conjunto, comparativamente tomados todos os membros da amostra. Conceituando formalmente a eficiência técnica mensurada pelo DEA, é preciso considerar o conjunto de atividades do programa como um sistema de produção que transforma "N" recursos, representados pelo vetor de quantidades X = (x1, x2, ...xN) RN, em "M" resultados, cujas quantidades são representadas em um vetor Y = (y1, y2,...,yM) RM. Esses vetores determinam um plano de operação descrito pelo vetor (x, y) RN+M. Quando observados "K" planos descritos pela produção observada de "K" programas, obtém-se como resultado uma matriz de eficiências individuais relativas à eficiência do grupo que pode ser expressa, individualmente, pela equação (1).

Onde:

i: quantidade do recurso empregado;

j: quantidade de resultado com ele produzido;

p e q: são vetores de pesos utilizados para a agregação dos recursos e dos resultados do programa avaliado;

Pr0: é a medida de produtividade do programa em avaliação.

A associação de um conjunto de pesos específicos para cada programa estudado permite a definição de uma medida de produtividade específica determinando um vetor de pesos (p, q), que corresponde às taxas de substituição técnicas entre os recursos e entre os resultados. Dessa forma, os pesos (p, q) podem reproduzir a utilidade que o programa atribui ao plano de produção por ele realizado (Moita, 2002). A determinação dos pesos do programa avaliado pode ser encontrada maximizando-se o valor da produtividade relativa "E0" por meio do problema de programação matemática expresso em (2).

Onde as restrições são:

Ej ≤ 1, ou seja, a eficiência do programa seja igual ou menor a 1;

e os vetores de pesos de recursos e resultados "pj" e "qi" sejam > 0.

A métrica DEA determina que os programas 100% eficientes (Ej = 1) transformem-se em parâmetros para o modelo, ou seja, constituem a fronteira de eficiência e todos os demais são avaliados em função deles. De acordo com Moita (2002), para cada desempenho ineficiente a técnica DEA identifica um conjunto de desempenhos eficientes que formam um grupo de referência para análise da eficiência do programa em avaliação. As unidades determinantes de referência caracterizam uma faceta da fronteira de eficiência que representa o benchmark do programa avaliado, enquanto seus pesos ótimos representam as taxas de substituição das relações entre as variáveis. Entende-se que cada faceta determina a utilidade que os programas que a compõem atribuem aos seus insumos e produtos. Os programas então são agrupados conforme a ênfase própria atribuída às suas atividades, respeitando sua ênfase particular e dedicação peculiar às atividades produção científica e ou formação discente.

Para a aplicação DEA, é preciso classificar o conjunto de variáveis envolvidas em variáveis de entrada: recursos, e variáveis de saída: resultados. As variáveis de entrada são consideradas fatores de produção na análise e de saída os resultados por esses produzidos. Na avaliação da eficiência de programas de pós-graduação, os produtos que podem ser observados envolvem os resultados obtidos, como sugerem os parâmetros de avaliação de desempenho de programas de pós-graduação stricto sensu propostos pela CAPES, em formação de discentes (incluindo quantidade e tempo médio relativo para formação), orientação desses em projetos de pesquisa e a produção científica própria por meio de seu corpo docente.

Como variáveis de resultados, foram considerados o número de alunos titulados pelo programa no triênio, o tempo médio de titulação discente no programa, o número de discentes autores e o desempenho do programa em pesquisa. Como a proxy para o desempenho docente em pesquisa foi adotada a pontuação docente no conjunto de publicações obtidas nos diferentes meios classificados pelo Qualis, no triênio 2007-2009. A variável tempo médio de titulação discente teve de ser ajustada para atender aos requisitos do modelo, uma vez que a lógica do DEA envolve o uso de variáveis de resultados do tipo quanto maior melhor. Em termos reais, a eficiência dessa variável possui a lógica de quanto menor melhor e, por essa razão, o ajuste foi necessário. Utilizou-se, portanto, a diferença entre 100 e o tempo real de titulação discente como proxy para a variável.

Como variáveis de recursos, na outra dimensão do modelo, consideraram-se como principais insumos para o desempenho do programa o número total de docentes, o número de docentes permanentes no programa, o número de linhas de pesquisa e de projetos de pesquisa no programa e o número de disciplinas ofertadas. A Figura 1 retrata resumidamente as variáveis consideradas na análise.

Figura 1 - Descrição das variáveis de entrada e saída

Fonte: dados da pesquisa.

Todos os dados empregados para alimentação das variáveis de entrada e de saída foram obtidos nos relatórios publicados pela CAPES (2010). Após a construção das fronteiras de eficiência e análise dos programas a partir desses resultados, comparou-se a eficiência verificada nos programas com o conceito obtido pelos mesmos na avaliação do período para avaliar a consistência. É neste sentido que se insere esta pesquisa que procura contribuir com a temática da avaliação de desempenho nos cursos de pós-graduação Stricto Sensu, reforçando a utilização da Análise Envoltória de Dados.

4. Apresentação e análise dos resultados

4.1. Análise descritiva dos programas

Para traçar um panorama dos programas analisados, estimaram-se estatísticas descritivas que se apresentam na Tabela 1.

Tabela 1 - Estatística descritiva dos dados

Variáveis |

No. de observações |

Mínimo |

Máximo |

Média |

Desvio-padrão (n) |

Alunos Titulados |

8 |

2 |

94 |

40,37 |

30,04 |

Tempo titulação |

8 |

24 |

35,7 |

24,82 |

10,76 |

Discentes autores |

8 |

2 |

75 |

34,50 |

26,39 |

Pontuação docente |

8 |

700 |

3980 |

1628,75 |

1273,14 |

Docentes |

8 |

9 |

15 |

12,25 |

1,83 |

Docentes Permanentes |

8 |

9 |

16 |

12 |

2,13 |

Linhas Pesquisa |

8 |

2 |

12 |

4,75 |

3,19 |

Projetos pesquisa |

8 |

11 |

43 |

23,25 |

11,22 |

Disciplinas Ofertadas |

8 |

16 |

46 |

24,62 |

10,55 |

Fonte: dados da pesquisa.

Ao analisar a Tabela 1, verifica-se que há uma grande variação entre o número de alunos titulados, sendo que o número mínimo foi de 2 e o máximo 94 alunos no triênio avaliado. O tempo de titulação é uma variável que tem uma variação entre 24 e 35,7 meses, no qual a média de titulação dos alunos dos programas analisados é de 40,37 meses. Observa-se uma dispersão média no número de projetos de pesquisa, variando entre 11 e 43 projetos por programa. Em relação à pontuação em publicações observam-se programas com a pontuação de 700 pontos e outros com até 3980 pontos. Referindo-se ao número de discentes autores, verifica-se que mínimo foi de 2 e o máximo de 75. O número de docentes pesquisadores por programa varia de 9 a 16, com média de 15 docentes por programa. O número de disciplinas ofertadas foi de no mínimo 16 e no máximo 46, obtendo uma média de 24,62 disciplinas por programa. Também foi verificada variação no número de linhas de pesquisa que apresentou de 2 a 12 linhas por programa.

A Tabela 2 apresenta os dados coletados para cada Programa que compõe a amostra de acordo com as variáveis de resultados, outputs e de recursos, inputs.

Tabela 2 - Caracterização dos Programas - variáveis de Resultado (Outputs) e Recursos (Inputs)

P |

Resultados (Outputs) |

Recursos (Inputs) |

|||||||

Alunos Titulados |

Tempo Titulação |

Discentes autores |

Pontuação docentes |

Docentes |

Docentes Permanentes |

Linhas Pesquisa |

Projetos pesquisa |

Disciplinas Ofertadas |

|

1 |

54 |

25,6 |

75 |

3.340 |

12 |

11 |

2 |

11 |

18 |

2 |

36 |

24 |

64 |

3.980 |

9 |

14 |

5 |

26 |

35 |

3 |

51 |

29 |

46 |

790 |

12 |

12 |

2 |

23 |

19 |

4 |

94 |

30,3 |

43 |

1.060 |

11 |

16 |

5 |

43 |

25 |

5 |

45 |

24 |

14 |

1.120 |

12 |

12 |

5 |

19 |

16 |

6 |

2 |

30 |

16 |

700 |

15 |

11 |

3 |

11 |

46 |

7 |

0 |

0 |

2 |

1.020 |

14 |

9 |

4 |

18 |

20 |

8 |

41 |

35,7 |

16 |

1.020 |

13 |

11 |

12 |

35 |

18 |

Legenda: Administração: 1; Ciências Contábeis: 2; Desenvolvimento Regional: 3; Educação: 4; Engenharia Ambiental: 5; Engenharia Elétrica: 6; Engenharia Química: 7; Química: 8. |

|||||||||

Fonte: dados da pesquisa

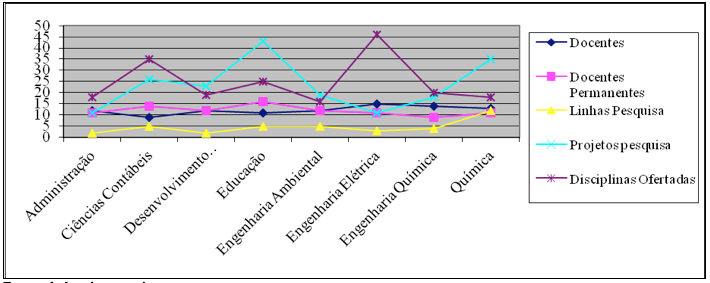

Na análise da Tabela 2, observa-se as características de cada Programa de acordo com as variáveis Outputs e Inputs. Verifica-se que o Programa que obteve o maior número de alunos titulados foi o de Educação com 94 alunos titulados. O Programa de Engenharia Elétrica apresentou o menor número, 2 alunos titulados no triênio. O Programa de Engenharia Química não apresentou resultados devido ao tempo de sua criação e análise do triênio. O Programa de Administração apresentou o maior número de alunos autores com 75 estudantes, enquanto o de Engenharia Química apresentou 2 alunos autores. Com relação à pontuação docente, o Programa que apresentou a maior pontuação foi o de Ciências Contábeis, totalizando 3.980 pontos, e a menor pontuação foi observada no Programa de Engenharia Elétrica, com 700 pontos. Já observando as variáveis definidas como Inputs. Verifica-se que em relação ao número de docentes e número de docentes permanentes, o Programa de Desenvolvimento Regional apresentou o mesmo número, sendo 12 respectivamente. O Programa de Engenharia Química foi o que apresentou o menor número de professores permanentes, totalizando 9. Tratando-se das linhas de pesquisa, observa-se que o programa que apresentou o maior número de linhas de pesquisa foi o de Química, sendo 12 no total, e dois apresentaram o menor número de linhas de pesquisa: Administração e Desenvolvimento Regional. Em relação ao número de projetos de pesquisa, verifica-se uma diferença grande em relação aos Programas. O que apresentou o maior número de projetos de pesquisa foi o Programa de Educação com 43 projetos e, dois programas apresentaram o menor número de projetos, Administração e Engenharia Elétrica com apenas 11 projetos no triênio. Em relação a quantidade de disciplinas ofertadas, o Programa de Engenharia Elétrica apresentou o maior número de disciplinas, 46, e o Programa de Engenharia Ambiental apresentou a menor quantidade, totalizando 16. A Figura 2 apresenta graficamente os recursos dos programas e seus conceitos.

Figura 2 - Recursos dos Programas com Conceito

Fonte: dados da pesquisa.

Ao observar a Figura 2, verifica-se que dentre os recursos de cada programa o número de projetos de pesquisa e disciplinas ofertadas são os recursos que mais apresentam variação e os que apresentam a menor variação é o numero de linhas de pesquisa e os docentes permanentes.

4.2. Análise da eficiência a partir da Data Envelopment Analysis (DEA)

A Tabela 3 apresenta a analise da eficiência dos programas da universidade em estudo.

Tabela 3 - Eficiência DEA

Programa |

Resultados (Outputs) |

DEA |

Conceito |

|||

Alunos Titulados |

Tempo Titulação |

Discentes autores |

Pontuação docentes |

Eficiência |

||

Administração |

54 |

25,6 |

75 |

3.340 |

0,42898847 |

4 |

Ciências Contábeis |

36 |

24 |

64 |

3.980 |

0,40217669 |

4 |

Desenvolvimento Regional |

51 |

29 |

46 |

790 |

0,48596350 |

4 |

Educação |

94 |

30,3 |

43 |

1.060 |

0,50774807 |

3 |

Engenharia Ambiental |

45 |

24 |

14 |

1.120 |

0,40217669 |

3 |

Engenharia Elétrica |

2 |

30 |

16 |

700 |

0,50272086 |

3 |

Engenharia Química |

0 |

0 |

2 |

1.020 |

0,00000000 |

3 |

Química |

41 |

35,7 |

16 |

1.020 |

0,598237823 |

3 |

Programa |

Recursos (Inputs) |

Conceito |

||||

Docentes |

Docentes Permanentes |

Linhas Pesquisa |

Projetos pesquisa |

Disciplinas Ofertadas |

||

Administração |

12 |

11 |

2 |

11 |

18 |

4 |

Ciências Contábeis |

9 |

14 |

5 |

26 |

35 |

4 |

Desenvolvimento Regional |

12 |

12 |

2 |

23 |

19 |

4 |

Educação |

11 |

16 |

5 |

43 |

25 |

3 |

Engenharia Ambiental |

12 |

12 |

5 |

19 |

16 |

3 |

Engenharia Elétrica |

15 |

11 |

3 |

11 |

46 |

3 |

Engenharia Química |

14 |

9 |

4 |

18 |

20 |

3 |

Química |

13 |

11 |

12 |

35 |

18 |

3 |

Fonte: dados da pesquisa.

A análise da eficiência dos programas de Pós-Graduação por meio da técnica DEA permitiu constatar a possibilidade de corroboração da hipótese levantada de que os programas enquadrados pela avaliação CAPES sob os mesmos conceitos ou notas podem estar apresentando níveis de eficiência diferenciados e que a avaliação levada sob tais parâmetros, pode estar prejudicando programas na obtenção de recursos e favorecendo ineficientes por incorporar dentre os parâmetros e padrões observados recursos e produtos e por não avaliar o emprego dos recursos, apenas sua existência.

Na Tabela 3, a análise da eficiência dos programas demonstrou que 7 dos 8 programas da amostra são considerados ineficientes, ou seja, 94% da amostra não estão conseguindo aproveitar os recursos de que dispõem da forma mais produtiva possível. O Programa de Química apresenta está mais próximo da fronteira de eficiência, com coeficiente acima de 50%, ou seja, 59,8%. Outros programas estão muito aquém do desempenho que se espera, como o programa de Engenharia Química, que não apresenta coeficiente de eficiência. Observando a partir da nota do programa na avaliação da CAPES, oberva-se que todos os programas possuem nota 4 e 3.

Verifica-se que alguns programas, apesar de terem obtido nota 4 na avaliação da CAPES, na análise de eficiência no grupo, se mostram significativamente abaixo da média que se espera de um programa nível 4, como é o caso do Programa de Administração, Ciências Contábeis e Desenvolvimento Regional, que estão abaixo do Programa de Química, de nível 3 e que no entanto, obteve o maior coeficiente de eficiência da pesquisa. Verifica-se, também que, vale à pena se questionar se, na análise do desempenho de programas para a concessão de recursos destinados ao financiamento de pesquisas ou de atividades de formação discente, os programas que obtiveram notas superiores na avaliação CAPES realmente teriam mérito superior aos que se mostraram eficientes no emprego de recursos, independentemente de suas notas.

5. Considerações finais e sugestões de pesquisa futura

O objetivo deste artigo foi avaliar a eficiência dos programas de Stricto Sensu de uma Universidade privada, localizada na região Sul do Brasil. Foi utilizado como métrica a DEA, em que se tomou como variáveis de entrada o (i) número total de docentes, (ii) o número de docentes permanentes no programa, (iii) o número de linhas de pesquisa no programa, ( iv) o número de projetos de pesquisa no programa e (v) o número de disciplinas ofertadas. Como variáveis de saída, (i) o número de alunos titulados pelo programa no triênio, (ii) o tempo médio de titulação discente no programa, e o (iii) número de discentes autores e (iv) pontuação de pesquisa docente segundo critérios QUALIS.

Os resultados indicam que 94% da amostra, ou seja, 7 dos 8 cursos apresenta dificuldade para aproveitar os recursos disponíveis de forma eficiente. Foi verificado, também, que o sistema de avaliação atual tem agrupado programas com recursos e produtos bastante diferenciados, bem como tem ignorado a existência de programas eficientes em níveis superiores a outros que angariaram conceitos mais altos.

Como proposta de pesquisa futura, as constatações feitas neste estudo sugerem que investigações mais aprofundadas devem ser realizadas na busca de elaboração de instrumentos mais eficazes na avaliação do desempenho dos programas de forma a orientá-los em seus planos estratégicos e a orientar os agentes de fomento no destino adequado e justo dos recursos demandados pelas instituições.

Referências

Beckenkamp, M. T. (2002). Análise Envoltória de Dados: considerações sobre o estabelecimento de restrições para os multiplicadores ótimos. Dissertação de Mestrado, Programa de Pós-Graduação em Engenharia de Produção da Universidade Federal de Santa Catarina. Florianópolis: UFSC.

Belloni, J. A. (2000). Uma Metodologia de Avaliação da Eficiência Produtiva de Universidades Federais Brasileiras. Tese de Doutorado, Programa de Pós-Graduação em Engenharia de Produção da Universidade Federal de Santa Catarina. Florianópolis: UFSC.

CAPES (2010). Critérios de Avaliação da Área de Administração Contabilidade e Turismo (Triênio2007-2009). Disponível em: http://www.capes.gov.br/images/stories/download/avaliacao/ADMIN17jun10.pdf. Acesso em: 10 de maio de 2015.

Costa, H. G.; Motta, S. S.; Gutierrez, R. H. (2006). Avaliação da Produção Docente: abordagem multicritério pelo método Electre II. In XXVI ENEGEP, 2006, Fortaleza. Anais ... Fortaleza, ABEPRO, 9 a 11 de Outubro de 2006. CD ROM.

Durham, E. R. (1992). A institucionalização da Avaliação. In: DURHAN, Eunice R.; Schwartzman, Simon (org.). Avaliação do ensino superior. São Paulo: Edusp.

Fernades et al. (2015). Perceptions of university students regarding calories, food healthiness, and the importance of calorie information in menu labelling. Appetite, 91, 173-178.

Gatti, B. (2000). Reflexões sobre o desafio da Pós-graduação: novas perspectivas sociais, conhecimento e poder. In: José M. Nagamine. (Org.). Gestão acadêmica: desafios e perspectivas. 1. ed. São Paulo, SP: Ed. EDUC, 162-171.

Gil, A. C. (2002). Como elaborar projetos de pesquisa. 4ª ed. São Paulo: Atlas.

INFOCAPES (1996). Boletim informativo. Brasília: CAPES, 4(2).

Lapa, J. S.; Neiva, C. C. (1996). Avaliação em Educação: comentários sobre desempenho e qualidade. Ensaio, v.4, n. 12, jul/set, 213-236.

Liu, J. S., Lu, L. Y., Lu, W. M. (2016). Research fronts in data envelopment analysis. Omega, 58, 33-45.

Moita, M. H. V. (2002). Um modelo para Avaliação da Eficiência Técnica de Professores Universitários Utilizando Análise de Envoltória de Dados: o caso dos professores da área de engenharias. Tese de Doutorado, Programa de Pós-Graduação em Engenharia de Produção da Universidade Federal de Santa Catarina. Florianópolis: UFSC.

Neves, R. B; Costa, H.G. (2006). Avaliação de programas de pós-graduação: proposta baseada na integração ELECTRE TRI, SWOT e sistema CAPES, Revista Eletrônica Sistemas & Gestão, 1(3), 276-298.

Oliveira, R. T. Q.; Mello, J. M. C. (2006). Os programas de Pós-graduacao Stricto Sensu em História e Física da UFF no contextos das Avaliações CAPES e CNPQ. In III SEGeT, Simpósio de Excelência em Gestão e Tecnologia, 2006, Resende. Anais... Resende: Rio de Janeiro.

Paiva, F.C. (2000). Eficiência Produtiva de Programas de Ensino de Pós-Graduação em Engenharias: uma aplicação do método análise envoltória de dados – DEA. Dissertação de Mestrado, Programa de Pós-Graduação em Engenharia de Produção da Universidade Federal de Santa Catarina. Florianópolis: UFSC.

Souza, M. F. A. S.; Macedo, M. A. S. (2009). Análise de desempenho contábil-financeiro no setor bancário brasileiro por meio da aplicação da análise envoltória de dados (DEA). Revista Base, 6(2), 81-100.

Yang et al. (2011). Assessment of first-year post-graduate residents: Usefulness of multiple tools. Journal of the Chinese Medical Association, 75, 531-538.

Yang, M., Li, Y. J., Liang, L. (2015). A generalized equilibrium efficient frontier data envelopment analysis approach for evaluating DMUs with fixed-sum outputs. European Journal of Operational Research, 246, 2009-2017.

Veiga, C. R. P; Veiga, C. P. V.; Del Corso, J. M.; Silva, W. V. (2012). A Dinâmica da Inovação Tecnológica: Papel da Demanda Puxada, Tecnologia Empurrada e Incentivos Governamentais na Indústria Farmacêutica Brasileira. REGE Revista de Gestão, 19(4), 515-534. doi: 10.5700/rege476

Zhu, J. (2000) Multi-factor Performance Measure Model with Application to Fortune 500 Companies. European Journal of Operational Research, 123 (1), 105-124.

1. Pontifícia Universidade Católica do Paraná, PUCPR – Brasil – priscilla.bueno@pucpr.br

2. Pontifícia Universidade Católica do Paraná, PUCPR – Brasil – danitorres.rocha@gmail.com

3. Pontifícia Universidade Católica do Paraná – Brasil – claudimar.veiga@gmail.com

4. Universidade Federal do Paraná, UFPR - Brasil

5. Pontifícia Universidade Católica do Paraná – Brasil – luiz.duclos@pucpr.br